Il y a d’abord eu GPT, puis il y a eu Q.

Amazon Web Services a dévoilé une stratégie et des offres GenAI complètes à trois couches lors de re:Invent 2023, qui présentaient le nouvel assistant numérique intrigant Q en haut de la pile. Et même si Q a retenu l’essentiel de l’attention, il y avait de nombreux éléments interconnectés en dessous.

À chacune des trois couches – Infrastructure, Plateforme/Outils et Applications – AWS a lancé une combinaison de nouvelles offres et d’améliorations des produits existants qui s’associent pour former une solution complète dans le domaine brûlant de GenAI. Ou du moins, c’est ce qu’ils étaient censés faire. Cependant, le volume d’annonces dans un domaine peu connu a conduit à une confusion considérable quant à ce que l’entreprise avait exactement assemblé. Un rapide survol de l’actualité de re:Invent révèle une couverture divergente, indiquant qu’AWS doit encore clarifier ses offres.

Compte tenu du luxe d’un jour ou deux pour y réfléchir, ainsi que de la possibilité de poser beaucoup de questions, il m’apparaît désormais évident que la nouvelle approche d’Amazon en matière de GenAI est une stratégie globale et convaincante – même à ses débuts, il est vrai. Il est également évident que les efforts d’AWS au cours des dernières années ont consisté à introduire une gamme de produits et de services qui, à première vue, ne semblaient peut-être pas liés, mais qui constituaient les éléments constitutifs d’une stratégie plus large qui commence maintenant à émerger.

Les derniers efforts de l’entreprise commencent au niveau de sa couche d’infrastructure principale. Lors du salon re:Invent de cette année, AWS a lancé la puce accélératrice Trainium AI de deuxième génération, qui offre des améliorations 4 fois supérieures dans les charges de travail de formation de modèles d’IA par rapport à son prédécesseur. Ils ont également discuté de leur puce Inferentia 2, optimisée pour les efforts d’inférence de l’IA. Ensemble, ces deux puces – ainsi que le processeur Graviton de quatrième génération – offrent à Amazon une gamme complète de processeurs uniques qu’il peut utiliser pour créer des offres de calcul différenciées.

Adam Selipsky, PDG d’AWS, a également demandé à Jensen Huang, PDG de Nvidia, de le rejoindre sur scène pour annoncer de nouveaux partenariats entre les sociétés. Ils ont discuté des débuts du dernier GPU GH200 de Nvidia dans plusieurs nouvelles instances de calcul EC2 d’AWS et du premier déploiement tiers des systèmes DGX Cloud de Nvidia. En fait, les deux hommes ont même discuté d’une nouvelle version de la technologie d’interconnexion de puces NVLink de Nvidia qui permet à jusqu’à 32 de ces systèmes de fonctionner ensemble comme une usine informatique géante d’IA (nom de code Project Ceiba) qu’AWS hébergera pour les propres besoins de développement d’IA de Nvidia.

Passant à la plate-forme et aux outils, AWS a annoncé des améliorations critiques de sa plate-forme Bedrock. Bedrock se compose d’un ensemble de services qui vous permettent de tout faire : choisir le modèle de base de votre choix, déterminer comment vous choisissez de former ou d’affiner un modèle, déterminer les niveaux d’accès auxquels différentes personnes d’une organisation ont accès, choisir quels types d’informations sont autorisés et ce qui est bloqué (Bedrock Guardrails), et créez des actions basées sur ce que le modèle génère.

Dans le domaine du réglage des modèles, AWS a annoncé la prise en charge du réglage fin, de la pré-formation continue et, plus important encore, du RAG (Retrieval Augmented Generation). Ces trois éléments ont fait leur apparition relativement récemment et sont activement explorés par les organisations pour intégrer leurs propres données personnalisées dans les applications GenAI. Ces nouvelles approches sont importantes car de nombreuses entreprises commencent à se rendre compte qu’elles ne sont pas intéressées (ou, franchement, capables de) construire leurs propres modèles de base à partir de zéro.

Du côté des modèles de base, la gamme de nouvelles options prises en charge dans Bedrock comprend Meta’s Llama 2, Stable Diffusion et d’autres versions de la propre famille de modèles Titan d’Amazon. Compte tenu du récent investissement d’AWS dans Anthropic AI, il n’était pas surprenant de voir également un accent particulier mis sur le nouveau modèle Claude 2.1 d’Anthropic.

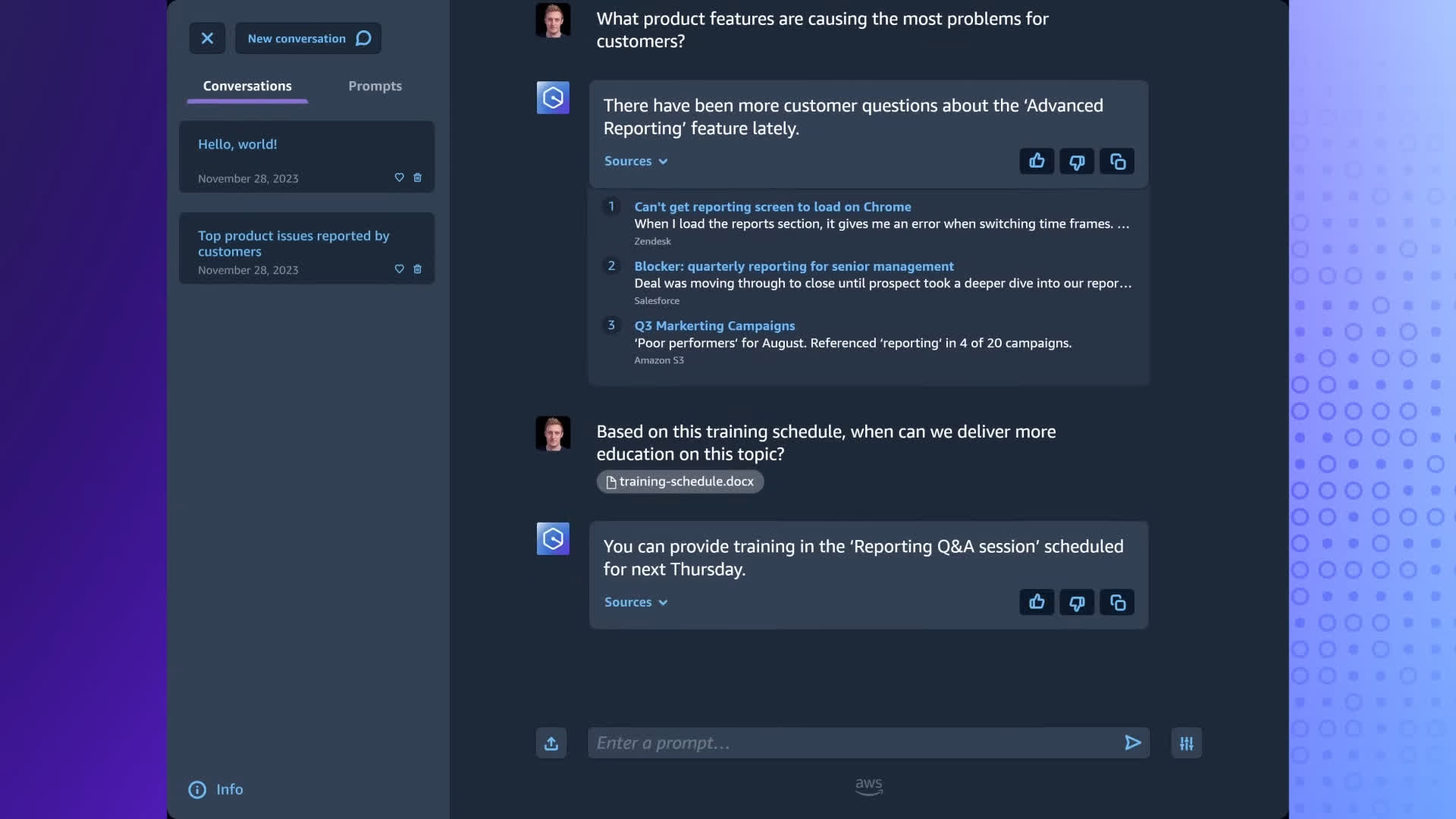

La dernière couche de l’histoire d’AWS GenAI est l’assistant numérique Q. Contrairement à la plupart des offres AWS, Q peut être utilisé comme une application GenAI finie de haut niveau que les entreprises peuvent commencer à déployer. Les développeurs peuvent personnaliser Q pour des applications spécifiques via des API et d’autres outils de la couche Bedrock.

Ce qui est intéressant à propos de Q, c’est qu’il peut prendre plusieurs formes. La version la plus évidente est une expérience de type chatbot similaire à celle proposée actuellement par d’autres entreprises. Sans surprise, la plupart des premiers reportages se sont concentrés sur cette interface utilisateur de chatbot.

Mais même dans cette première itération, Q peut offrir une variété de fonctionnalités. Par exemple, AWS a montré comment Q pouvait améliorer l’expérience de génération de code dans Code Whisperer d’Amazon, servir de transcripteur et de résumé d’appels pour la plateforme de service client Amazon Connect, simplifier la création de tableaux de bord de données dans les analyses Amazon QuickSight et servir de contenu. générateur et guide de gestion des connaissances pour les utilisateurs professionnels. Q peut utiliser différents modèles de base sous-jacents pour diverses applications, ce qui représente un type d’application d’assistant numérique plus étendu et plus performant que ceux proposés par certains concurrents, mais il est également beaucoup plus difficile pour les gens de s’y retrouver.

En approfondissant le fonctionnement de Q et ses connexions avec les autres parties d’AWS, il s’avère que Q a été construit via un ensemble d’agents Bedrock. Cela signifie donc que les entreprises qui recherchent une solution plus simple pour déployer des applications GenAI dans leur entreprise peuvent utiliser Q tel quel.

En revanche, les entreprises qui souhaitent proposer des solutions plus personnalisées peuvent créer certains de leurs propres agents Bedrock. Ce concept de capacités prédéfinies et personnalisables s’applique également à Bedrock et à l’outil SageMaker d’Amazon pour créer des modèles d’IA personnalisés. Bedrock est destiné à ceux qui souhaitent tirer parti d’une gamme de modèles de fondation déjà construits, tandis que SageMaker est destiné à ceux qui souhaitent créer leurs propres modèles.

En prenant du recul, vous pouvez commencer à apprécier le cadre complet et la vision qu’AWS a rassemblés. Cependant, il est également clair que cette stratégie n’est pas la plus intuitive à appréhender. Pour l’avenir, il est crucial qu’Amazon affine son message pour rendre son récit GenAI plus accessible et compréhensible à un public plus large. Cela permettrait à davantage d’entreprises de tirer parti de toute la gamme de capacités actuellement occultées dans le cadre.

Bob O’Donnell est le fondateur et analyste en chef de TECHnalysis Research, LLC, une société de conseil en technologie qui fournit des services de conseil stratégique et d’études de marché au secteur technologique et à la communauté financière professionnelle. Vous pouvez le suivre sur X @bobodtech