Il y aura un changement significatif vers la demande de personnalisation avec HBM4

En bref: Alors que l’IA générative engloutit de plus en plus de capacité, l’évolution des produits de mémoire à large bande passante sera la clé de son fonctionnement continu. Les fournisseurs déploient des produits HBM3 de deuxième génération, mais le véritable changement viendra avec HBM4.

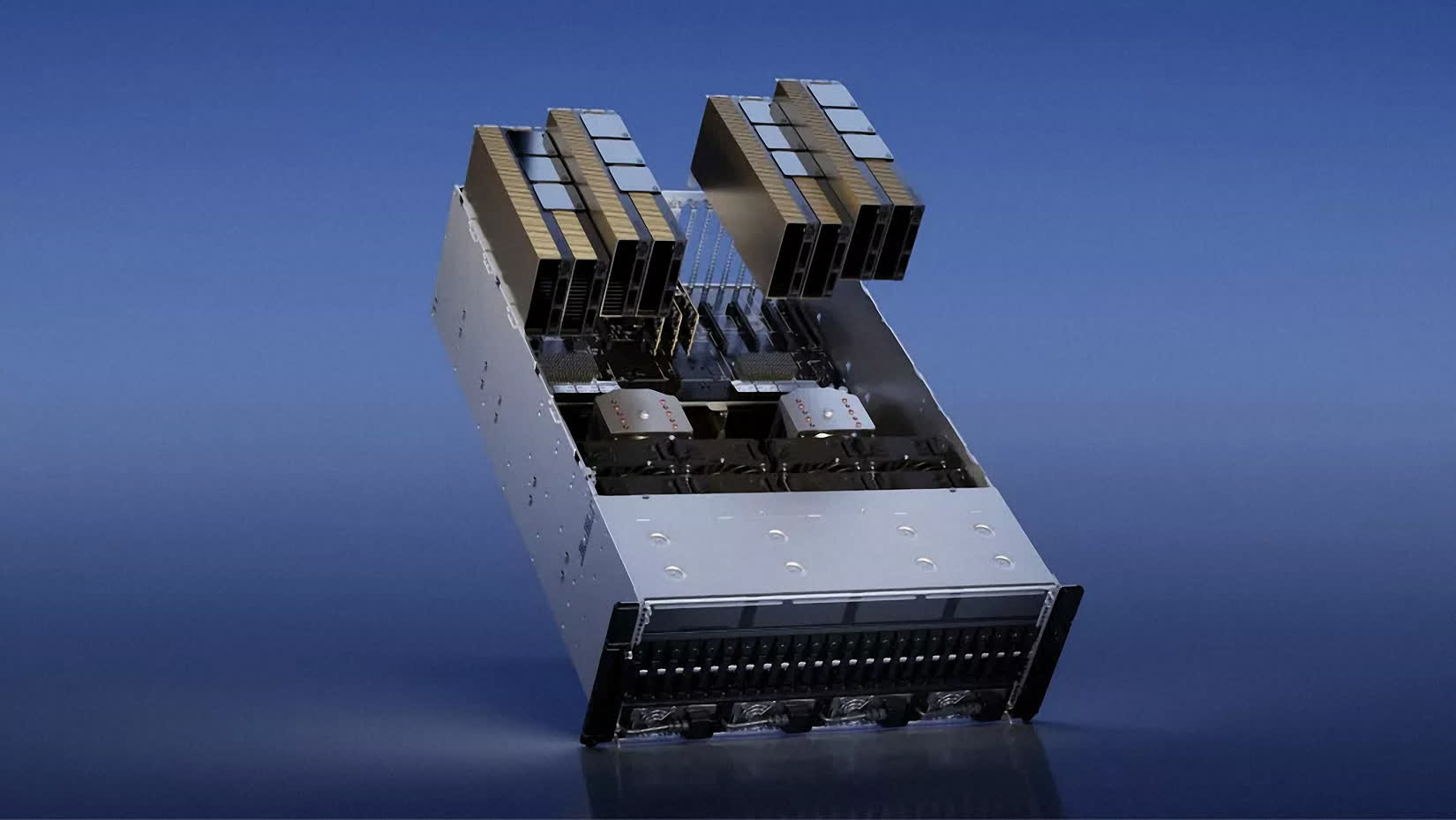

Le tout nouveau produit de mémoire à large bande passante de SK Hynix, HBM3E, est actuellement en production de masse et sera introduit sur le marché au premier semestre de cette année, selon les commentaires du vice-président Kim Chun-hwan lors de son discours d’ouverture au SEMICON Korea 2024 dernier. semaine. D’ici 2026, l’entreprise prévoit produire en masse le HBM4, son HBM de 6e génération, a-t-il ajouté.

Kim a également fourni des informations sur les produits flash DRAM et NAND de la société. Elle produit actuellement en masse des produits de largeur de ligne de circuit de niveau 1b et développe 1c, qui représente la prochaine génération, a-t-il déclaré. Cependant, SK Hynix prévoit de « sévères limitations technologiques » en dessous du niveau de 10 nanomètres et c’est pour cette raison que l’entreprise poursuit le développement de nouveaux matériaux et structures.

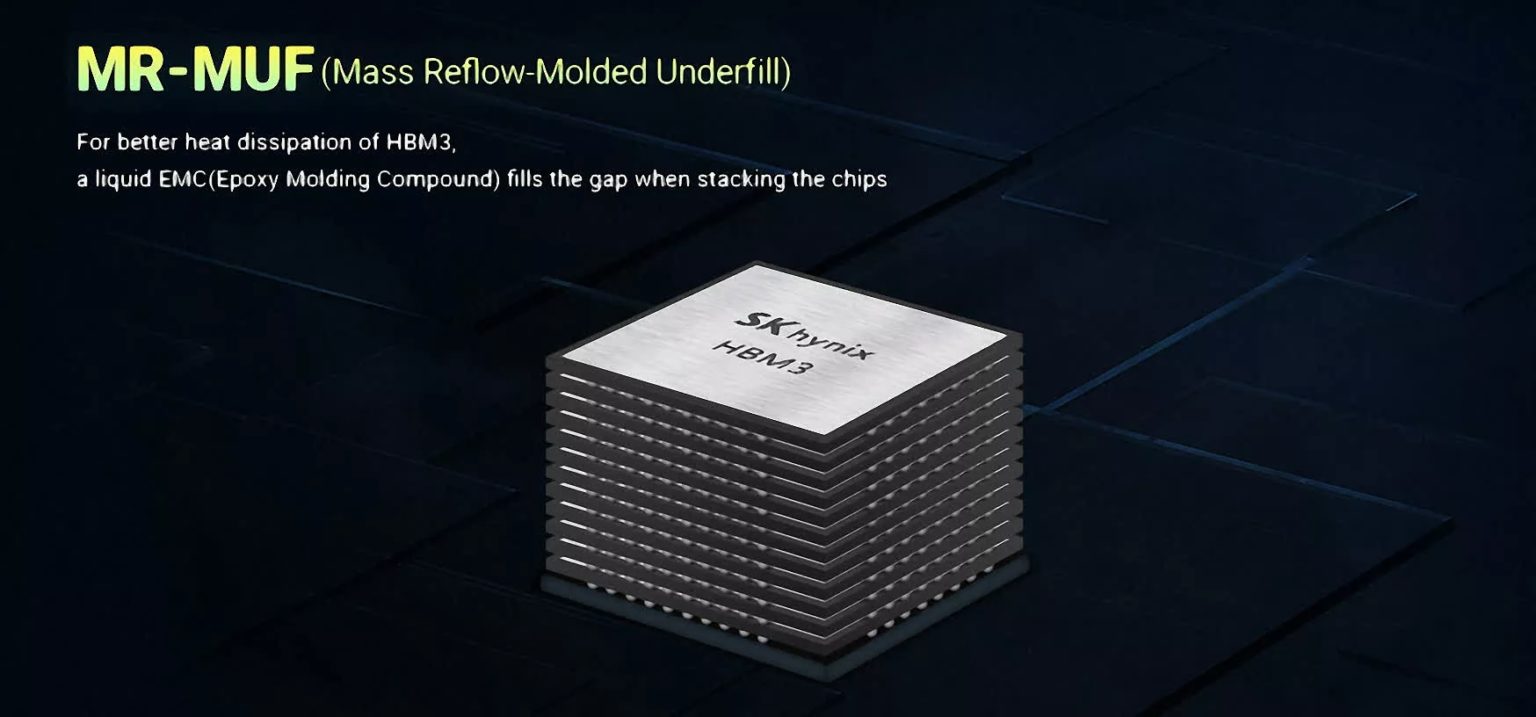

La croissance rapide de l’IA générative stimule la demande pour ces produits de mémoire, Kim notant que le marché de l’IA générative devrait croître à un taux annuel de 35 %. En particulier, la mémoire à large bande passante – introduite pour la première fois sur le marché en 2013 alors que l’on craignait qu’elle ne devienne jamais commercialement viable – permet les transferts de données ultra-rapides nécessaires à un grand nombre de ces applications. Pour ne citer qu’un exemple, Micron Technology se vante que sa mémoire HBM3 Gen2 avec une bande passante supérieure à 1,2 To/s et une vitesse de broche supérieure à 9,2 Gb/s réduit les temps de formation des grands modèles de langage comme GPT-4. Bref, les performances ont explosé.

La première itération de mémoire à large bande passante était quelque peu limitée, ne permettant que des vitesses allant jusqu’à 128 Go/s par pile. HBM2 a doublé les vitesses potentielles à 256 Go/s par pile et la capacité maximale à 8 Go. En 2018, HBM2 a reçu une mise à jour appelée HBM2E, qui a encore augmenté les limites de capacité à 24 Go et apporté une nouvelle augmentation de vitesse, atteignant finalement 460 Go/s par puce à son apogée. La vitesse a encore doublé avec le déploiement de HBM3, jusqu’à un maximum de 819 Go/s par pile tandis que les capacités ont augmenté à 64 Go. Puis est arrivée une autre mise à niveau, HBM3E, qui a augmenté les vitesses théoriques jusqu’à 1,2 To/s par pile.

Tout au long de cette histoire, HBM a conservé la même interface de 1 024 bits par pile – une caractéristique déterminante de la technologie. Mais cela va changer avec HBM4, qui devrait avoir une interface de 2048 bits qui pourrait théoriquement doubler à nouveau les vitesses de transfert, en supposant que les fabricants soient capables de maintenir les mêmes taux de transfert, un exploit qui est incertain.

À mesure que les spécifications du HBM évoluent, le marché lui-même évolue également. Trendforce a rapporté l’année dernière que Nvidia prévoyait de diversifier ses fournisseurs de HBM pour une gestion de la chaîne d’approvisionnement plus robuste et plus efficace. Il prédit également une évolution significative vers la demande de personnalisation sur le marché du HBM4, s’éloignant de l’approche standardisée de la DRAM de base. Cette évolution vers la personnalisation devrait entraîner des stratégies de conception et de tarification uniques, a déclaré Trendforce, et ouvrir la voie à une ère de production spécialisée dans la technologie HBM.