La concurrence s’intensifie contre le H100 et les autres GPU Nvidia AI

Dans le contexte: Le secteur en plein essor de l’IA a propulsé les finances de Nvidia vers de nouveaux sommets, car ses GPU d’accélération de l’IA sont devenus très recherchés. Cependant, ces composants à usage général sont confrontés à une concurrence croissante, ce qui incite l’entreprise à développer des puces plus efficaces, adaptées à des clients et à des tâches spécifiques.

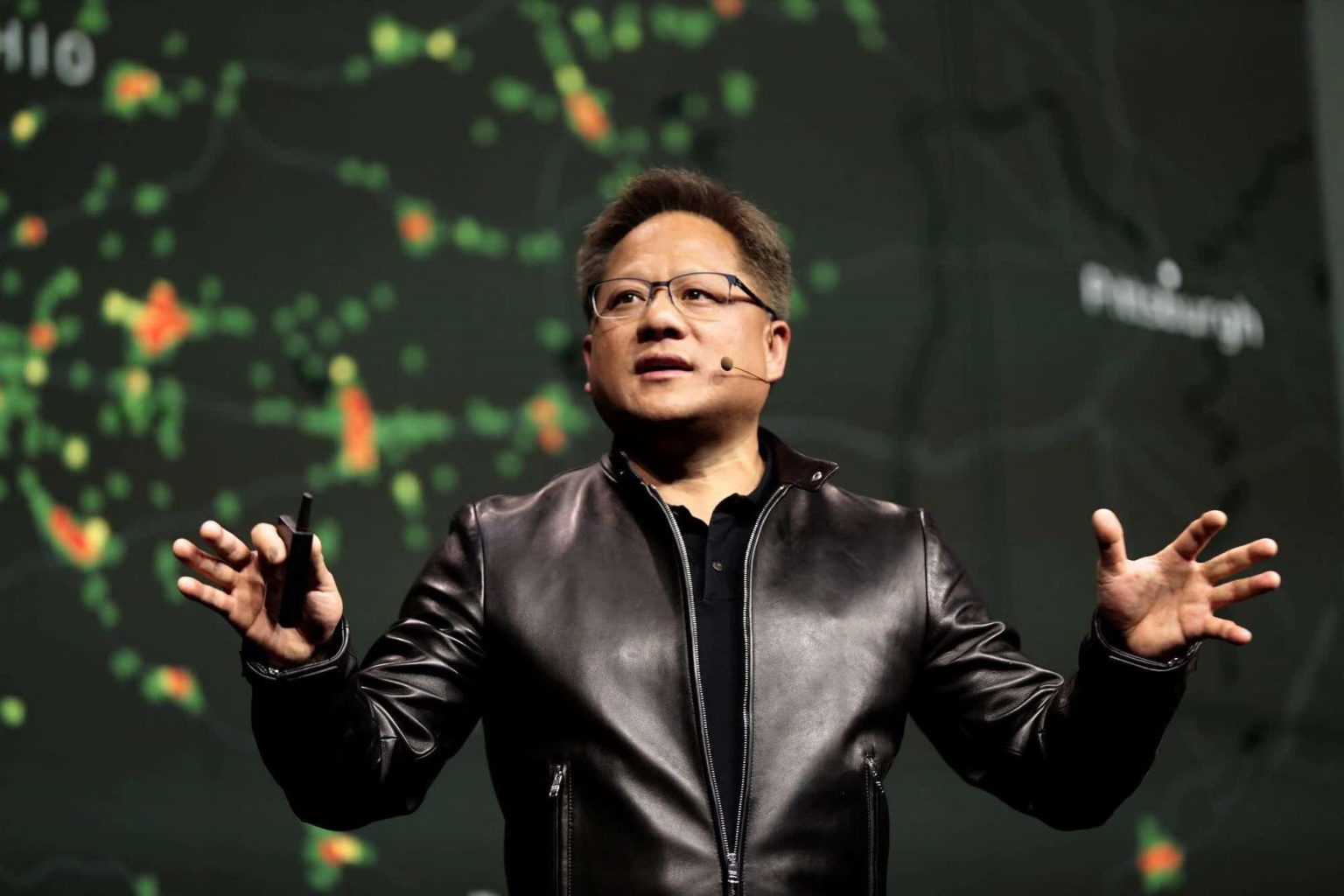

Des sources confidentielles ont déclaré à Reuters que Nvidia se lançait dans un projet de 30 milliards de dollars visant à créer une nouvelle unité de solutions de puces personnalisées. Les produits se concentreraient sur plusieurs secteurs, l’IA étant la principale préoccupation. La société aurait entamé des discussions avec Microsoft, Meta, Google et OpenAI.

Outre l’IA, la nouvelle unité pourrait également concevoir du matériel personnalisé de télécommunications, de cloud, d’automobile et de jeux. Par exemple, une grande partie de l’activité de son rival AMD provient de la conception de processeurs personnalisés pour les consoles Xbox et PlayStation. L’effort coûteux de Nvidia vers du matériel personnalisé est probablement une réponse à l’intensification de la concurrence dans le domaine de l’IA générative, qui a fait gonfler les bénéfices de l’entreprise.

Depuis le début de l’engouement pour l’IA générative, Nvidia a considérablement augmenté le cours de ses actions et sa capitalisation boursière en vendant des GPU pour centres de données H100 avec un bénéfice de 1 000 %. Bien que l’entreprise ne révèle pas ses dépenses, les estimations indiquent que la fabrication d’un H100 coûte quelques milliers de dollars, alors qu’ils se vendent entre 25 000 et 60 000 dollars.

Malgré leur prix astronomique, les clients ne s’en lassent pas. Meta prévoit d’acheter des centaines de milliers de H100 avant la fin de l’année. La situation a poussé les actions de Nvidia à plus de 720 dollars cette semaine, en hausse de 50 % depuis le début de l’année et de plus de 200 % par rapport à 2022 – la capitalisation boursière de la société de 1 770 milliards de dollars n’est que légèrement derrière Amazon et Alphabet.

Les puces H100, A100 et H200 AI de Nvidia dominent actuellement les marchés des charges de travail d’IA à usage général et de calcul haute performance. Cependant, une concurrence de plus en plus vive émerge de la part de sociétés comme AMD, qui affirme que son MI300X surpasse le H100 à une fraction du prix.

En outre, d’autres sociétés conçoivent du silicium exclusif, qui permet un meilleur contrôle des coûts et de la consommation d’énergie. L’empreinte énergétique de l’IA générative se rapproche de celle des petits pays. L’amélioration de l’efficacité est donc devenue un domaine de recherche majeur dans le secteur, où un matériel sur mesure pourrait devenir essentiel. À la fin de l’année dernière, Amazon a dévoilé le Trainium2 et le Graviton4 basé sur Arm, qui promettent des gains d’efficacité significatifs.