Cela pourrait changer la donne pour les applications d'IA et de HPC

En bref: Les GPU ont des limites de mémoire lorsqu'ils doivent faire face aux exigences des applications d'IA et de calcul haute performance. Il existe des moyens de contourner ce goulot d'étranglement, mais les solutions peuvent être coûteuses et fastidieuses. Aujourd'hui, une start-up basée à Daejeon, en Corée du Sud, a développé une nouvelle approche : utiliser la mémoire attachée au PCIe pour augmenter la capacité. Le développement de cette solution a nécessité de franchir de nombreux obstacles technologiques et il reste encore des défis à relever. À savoir, AMD, Intel et Nvidia prendront-ils en charge cette technologie ?

Les besoins en mémoire liés aux jeux de données avancés pour les applications d'IA et de calcul haute performance (HPC) surchargent souvent la mémoire intégrée à un GPU. L'extension de cette mémoire implique généralement l'installation d'une mémoire coûteuse à bande passante élevée, ce qui introduit souvent des modifications dans l'architecture ou le logiciel GPU existant.

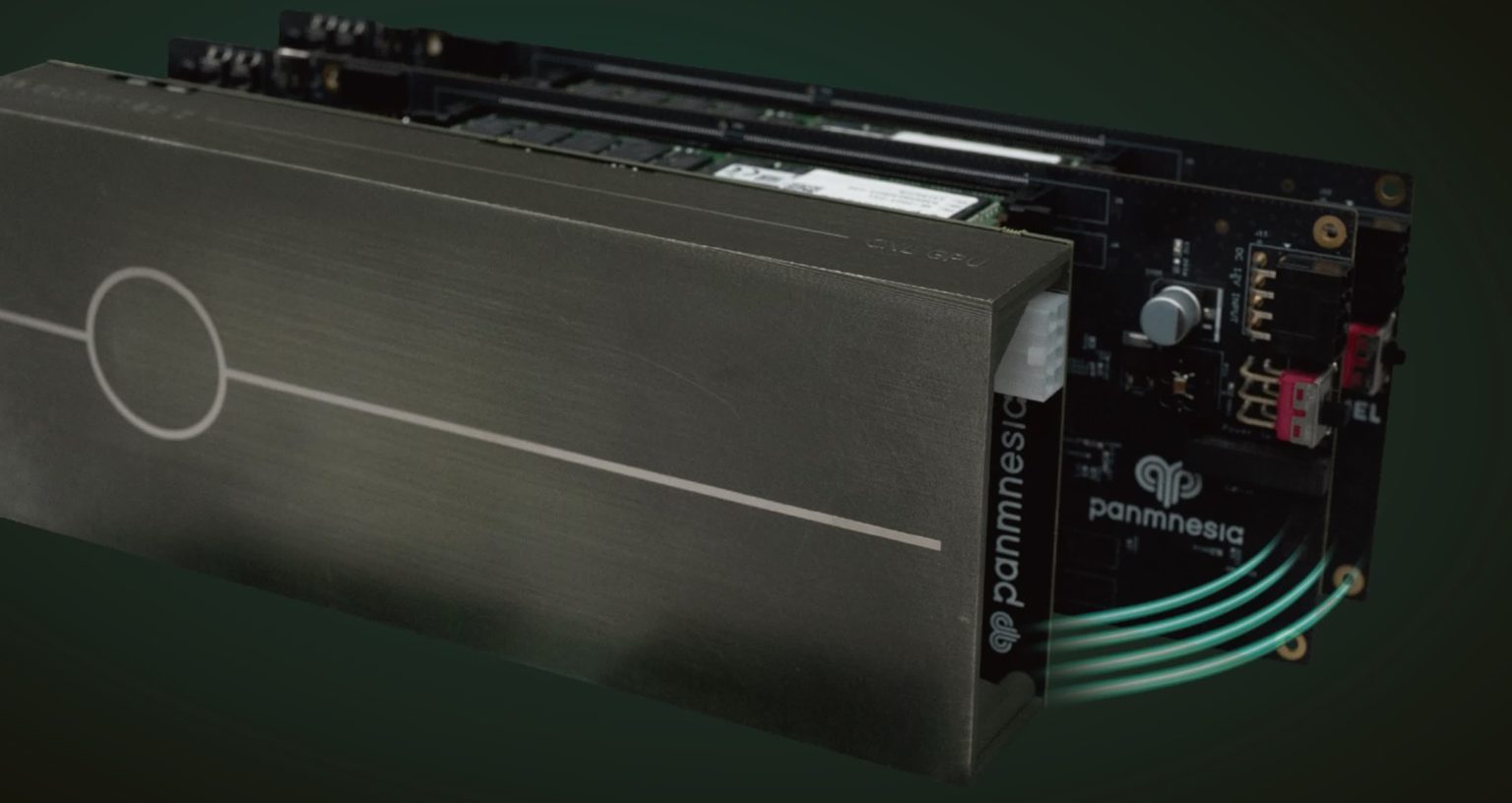

Panmnesia, une société soutenue par l'institut de recherche sud-coréen KAIST, propose une solution à ce problème. Elle a introduit une nouvelle technologie permettant aux GPU d'accéder directement à la mémoire système via une interface Compute Express Link (CXL). En fait, elle permet aux GPU d'utiliser la mémoire système comme une extension de leur propre mémoire.

Appelée CXL GPU Image, cette mémoire connectée PCIe a une latence à deux chiffres en nanosecondes qui est nettement plus rapide que les SSD traditionnels, selon la société.

Panmnesia a dû surmonter plusieurs défis techniques pour développer ce système.

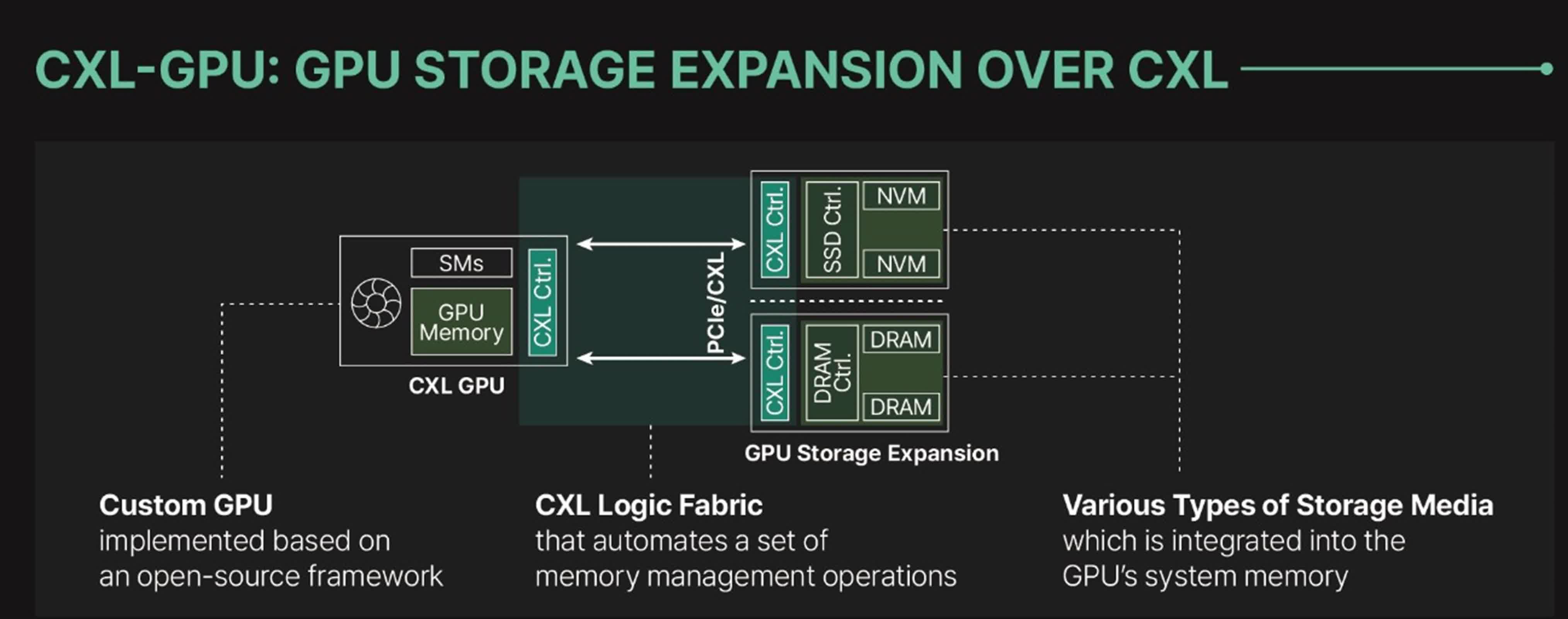

CXL est un protocole qui fonctionne sur une liaison PCIe, mais la technologie doit être reconnue par un ASIC et son sous-système. En d'autres termes, il n'est pas possible d'ajouter simplement un contrôleur CXL à la pile technologique car il n'existe pas de structure logique CXL ni de sous-systèmes prenant en charge les points de terminaison DRAM et/ou SSD dans les GPU.

De plus, les sous-systèmes de mémoire et de cache du GPU ne reconnaissent aucune extension, à l’exception de la mémoire virtuelle unifiée (UVM), qui n’est pas assez rapide pour l’IA ou le HPC. Lors des tests effectués par Panmnesia, UVM a obtenu les pires résultats parmi tous les noyaux GPU testés. Le CXL, cependant, a fourni un accès direct au stockage étendu via des instructions de chargement/stockage, éliminant les problèmes qui entravent UVM, tels que la surcharge due à l’intervention de l’hôte lors de l’exécution des erreurs de page et le transfert de données au niveau de la page.

En réponse, Panmnesia a développé une série de couches matérielles qui prennent en charge tous les protocoles CXL clés, les consolidant en un contrôleur unifié.

Le complexe racine compatible CXL 3.1 dispose de plusieurs ports racine prenant en charge la mémoire externe via PCIe et d'un pont hôte avec un décodeur de mémoire de périphérique géré par l'hôte qui se connecte au bus système du GPU et gère la mémoire système.

Panmnesia doit faire face à d’autres défis qui échappent à son contrôle, notamment la nécessité pour AMD et Nvidia d’ajouter le support CXL à leurs GPU. Il est possible que les acteurs du secteur décident qu’ils apprécient l’approche consistant à utiliser de la mémoire PCIe pour les GPU et qu’ils développent ensuite leur propre technologie.