La société affirme qu'elle reste engagée sur le marché des GPU grand public

Que vient-il de se passer ? L'Instinct MI300 d'AMD s'est rapidement imposé comme un acteur majeur sur le marché des accélérateurs d'IA, entraînant une croissance significative des revenus. Même s'il ne peut espérer rivaliser avec la position dominante de Nvidia sur le marché, les progrès d'AMD indiquent un avenir prometteur dans le secteur du matériel d'IA.

Le GPU Instinct MI300 récemment lancé par AMD est rapidement devenu un énorme moteur de revenus pour l'entreprise, rivalisant avec l'ensemble de son activité CPU en termes de ventes. Il s’agit d’une étape importante pour AMD sur le marché concurrentiel du matériel d’IA, où il est traditionnellement à la traîne du leader du secteur Nvidia.

Lors de la dernière conférence téléphonique sur les résultats de la société, Lisa Su, PDG d'AMD, a déclaré que l'activité GPU pour centres de données, principalement portée par l'Instinct MI300, avait dépassé les attentes initiales. « Nous constatons actuellement que notre activité GPU (IA) se rapproche vraiment de l'échelle de notre activité CPU », a-t-elle déclaré.

Cette réalisation est particulièrement remarquable étant donné que l'activité CPU d'AMD englobe une large gamme de produits pour les serveurs, le cloud computing, les ordinateurs de bureau et les ordinateurs portables.

L'Instinct MI300, lancé en novembre 2023, représente le premier GPU véritablement compétitif d'AMD pour les charges de travail d'inférence et de formation de l'IA. Malgré son lancement relativement récent, le MI300 a rapidement gagné du terrain sur le marché.

Les analystes financiers estiment que les revenus des GPU AI d'AMD pour le seul mois de septembre étaient supérieurs à 1,5 milliard de dollars, les mois suivants montrant probablement des performances encore plus fortes.

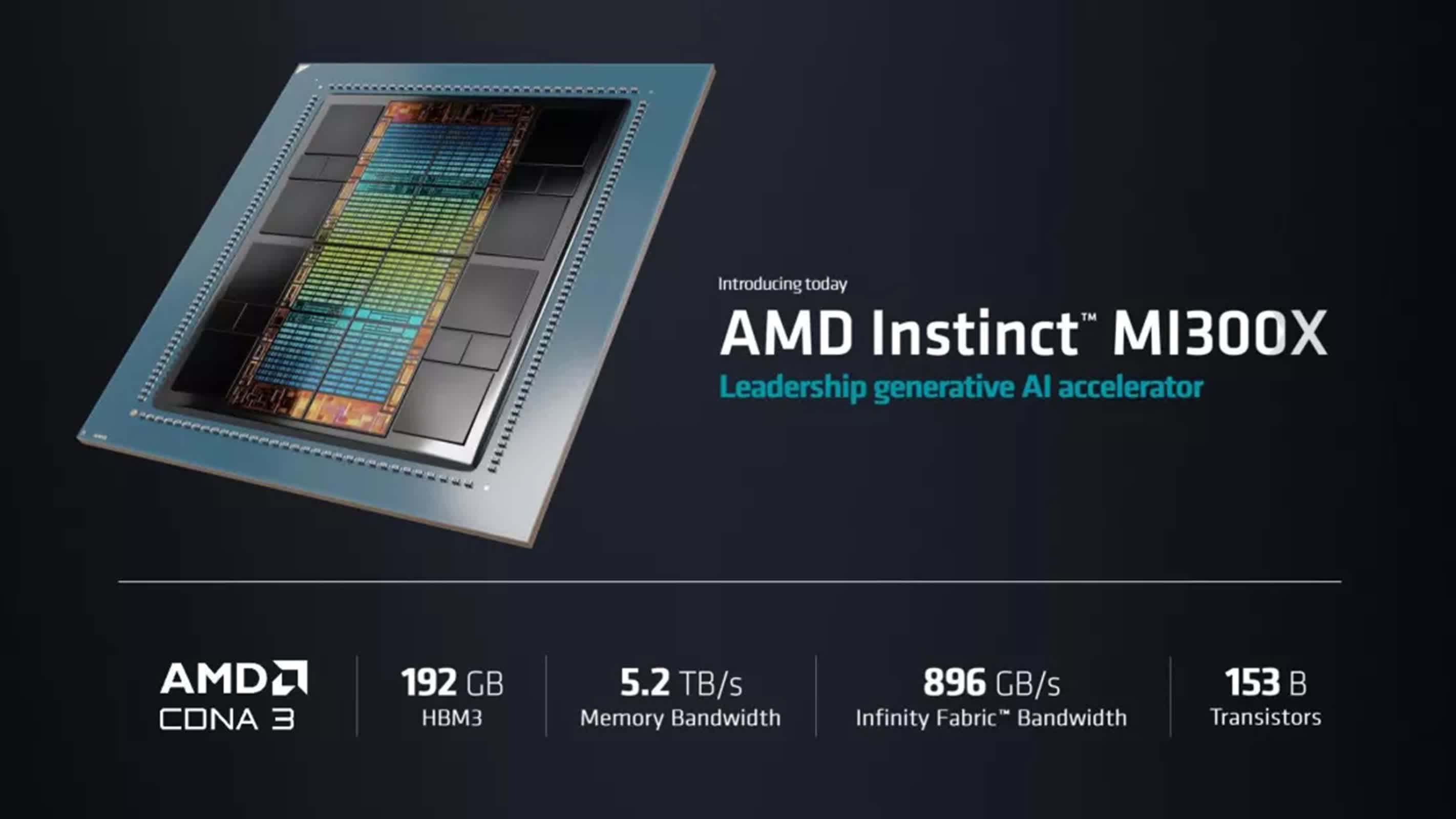

Les spécifications du MI300 sont très compétitives sur le marché des accélérateurs d'IA, offrant des améliorations significatives en termes de capacité de mémoire et de bande passante.

Le GPU MI300X dispose de 304 unités de calcul GPU et de 192 Go de mémoire HBM3, offrant une bande passante mémoire théorique maximale de 5,3 To/s. Il atteint des performances matricielles FP64/FP32 maximales de 163,4 TFLOPS et des performances FP8 maximales atteignant 2 614,9 TFLOPS.

L'APU MI300A intègre 24 cœurs de processeur Zen 4 x86 ainsi que 228 unités de calcul GPU. Il dispose de 128 Go de mémoire unifiée HBM3 et correspond à la bande passante mémoire théorique maximale du MI300X de 5,3 To/s. Les performances maximales de la matrice FP64/FP32 du MI300A s'élèvent à 122,6 TFLOPS.

Le succès de l'Instinct MI300 a également séduit de grands fournisseurs de cloud, comme Microsoft. Le fabricant de Windows a récemment annoncé la disponibilité générale de sa série ND MI300X VM, qui comprend huit accélérateurs AMD MI300X Instinct. Plus tôt cette année, Scott Guthrie, vice-président exécutif de Microsoft Cloud et IA, a déclaré que les accélérateurs d'AMD sont actuellement les GPU les plus rentables disponibles en fonction de leurs performances dans Azure AI Service.

Bien que la croissance d'AMD sur le marché des GPU AI soit impressionnante, la société reste à la traîne derrière Nvidia en termes de part de marché globale. Les analystes prévoient que Nvidia pourrait réaliser des ventes de GPU AI de 50 à 60 milliards de dollars en 2025, tandis qu'AMD pourrait atteindre au mieux 10 milliards de dollars.

Cependant, le directeur financier d'AMD, Jean Hu, a noté que la société travaille sur plus de 100 engagements clients pour la série MI300, notamment de grandes sociétés technologiques telles que Microsoft, Meta et Oracle, ainsi qu'un large éventail d'entreprises clientes.

Le succès rapide de l'Instinct MI300 sur le marché de l'IA soulève des questions sur l'orientation future d'AMD sur les cartes graphiques grand public, car les revenus nettement plus élevés provenant des accélérateurs d'IA pourraient influencer l'allocation des ressources de l'entreprise. Mais AMD a confirmé son engagement sur le marché des GPU grand public, Su annonçant que l'architecture RDNA 4 de nouvelle génération, qui fera probablement ses débuts sur la Radeon RX 8800 XT, arrivera début 2025.