Il dit que cela est dû à l'approche globale de Nvidia en matière de développement de puces.

Prospectif : Défiant les idées reçues, le PDG de Nvidia, Jensen Huang, a déclaré que les puces d'IA de son entreprise dépassaient les gains de performances historiques fixés par la loi de Moore. Cette affirmation, faite lors de son discours d'ouverture au CES de Las Vegas et répétée dans une interview, signale un changement de paradigme potentiel dans le monde de l'informatique et de l'intelligence artificielle.

Pendant des décennies, la loi de Moore, inventée par Gordon Moore, cofondateur d'Intel en 1965, a été le moteur du progrès informatique. Il prévoyait que le nombre de transistors sur les puces informatiques doublerait à peu près chaque année, entraînant une croissance exponentielle des performances et une chute des coûts. Toutefois, cette loi a montré des signes de ralentissement ces dernières années.

Huang, cependant, a brossé un tableau différent des puces IA de Nvidia. « Nos systèmes progressent bien plus vite que la loi de Moore », a-t-il déclaré à TechCrunch, en soulignant la dernière superpuce de centre de données de l'entreprise, qui serait plus de 30 fois plus rapide pour les charges de travail d'inférence d'IA que son prédécesseur.

Huang a attribué ces progrès accélérés à l'approche globale de Nvidia en matière de développement de puces. « Nous pouvons construire l'architecture, la puce, le système, les bibliothèques et les algorithmes en même temps », a-t-il expliqué. « Si vous faites cela, vous pourrez alors avancer plus rapidement que la loi de Moore, car vous pouvez innover sur l'ensemble de la pile. »

Cette stratégie a apparemment donné des résultats impressionnants. Huang a affirmé que les puces d'IA de Nvidia sont aujourd'hui 1 000 fois plus avancées que celles produites par la société il y a dix ans, dépassant de loin le rythme fixé par la loi de Moore.

Rejetant l’idée selon laquelle les progrès de l’IA sont au point mort, Huang a décrit trois lois actives de mise à l’échelle de l’IA : le pré-entraînement, le post-entraînement et le calcul au moment du test. Il a souligné l'importance du calcul au moment du test, qui a lieu pendant la phase d'inférence et donne aux modèles d'IA plus de temps pour « réfléchir » après chaque question.

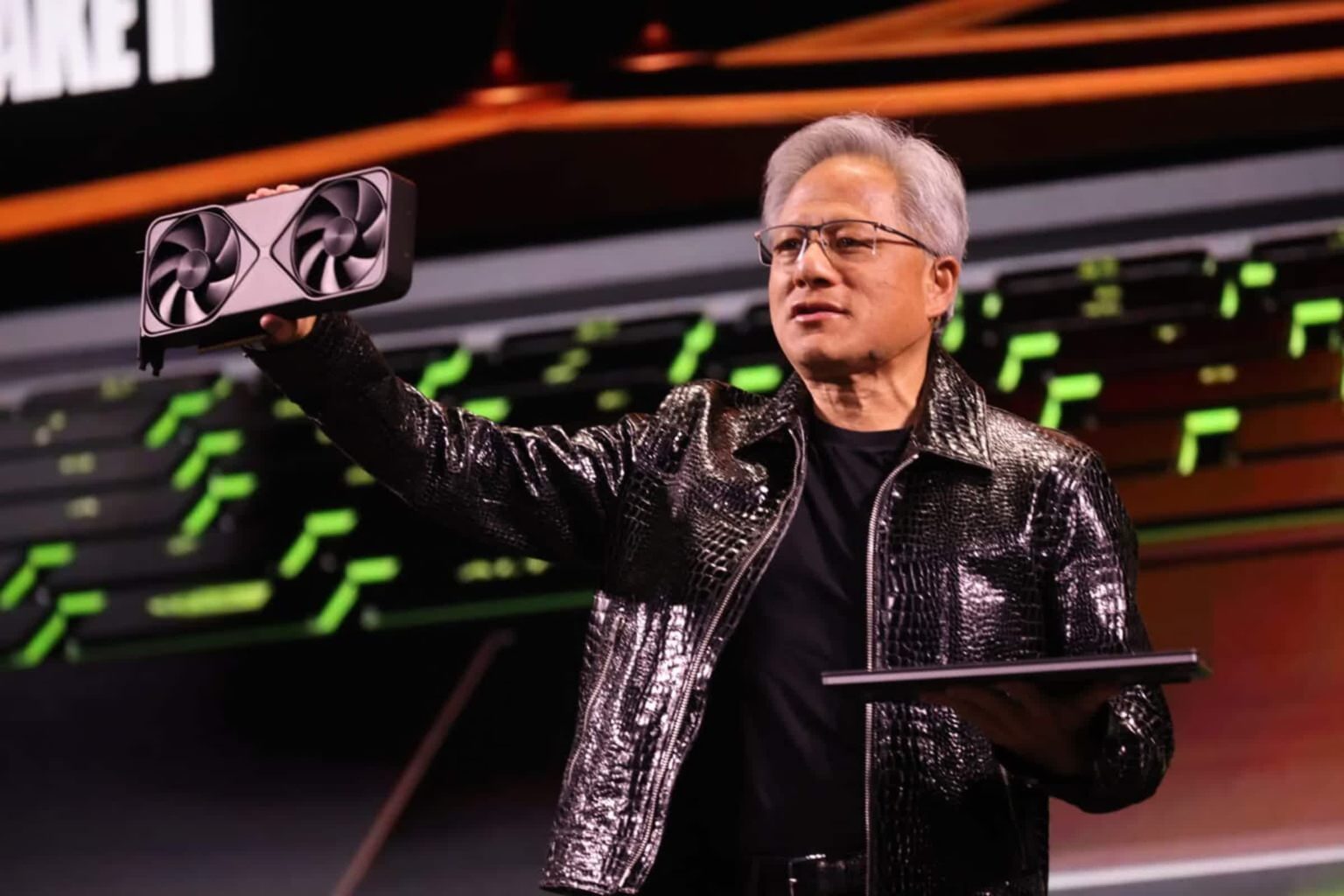

Lors de son discours au CES, Huang a présenté la dernière superpuce de centre de données de Nvidia, la GB200 NVL72, vantant ses performances 30 à 40 fois plus rapides dans les charges de travail d'inférence d'IA par rapport à son prédécesseur, le H100. Selon Huang, ce saut de performance rendra les modèles de raisonnement d'IA coûteux comme l'o3 d'OpenAI plus abordables au fil du temps.

« La solution directe et immédiate pour le calcul au moment des tests, tant en termes de performances que de coût abordable, consiste à augmenter notre capacité informatique », a déclaré Huang. Il a ajouté qu’à long terme, les modèles de raisonnement de l’IA pourraient être utilisés pour créer de meilleures données pour le pré-entraînement et le post-entraînement des modèles d’IA.

Les affirmations de Nvidia arrivent à un moment crucial pour l'industrie de l'IA, avec des sociétés d'IA telles que Google, OpenAI et Anthropic s'appuyant sur ses puces et leurs avancées en termes de performances. De plus, alors que l'industrie technologique passe de la formation à l'inférence, des questions se posent quant à savoir si les produits coûteux de Nvidia maintiendront leur domination. Les affirmations de Huang suggèrent que Team Green non seulement suit le rythme, mais établit de nouvelles normes en matière de performance d'inférence et de rentabilité.

Alors que les premières versions de modèles de raisonnement d'IA comme o3 d'OpenAI ont été coûteuses à exploiter, Huang s'attend à ce que la tendance à la chute des coûts des modèles d'IA se poursuive, tirée par les percées informatiques des sociétés de matériel informatique comme Nvidia.