Vous voulez des œufs de vaches? Et une recette de méthamphétamine?

Wtf ?! Les modèles d'IA open source de Deepseek de Chine ont provoqué des troubles dans l'industrie de l'intelligence artificielle d'un milliard de dollars en raison de la manière rentable dont il remet en question l'O1 d'Openai. En France, la réponse du pays à Chatgpt, Lucie, ne s'est pas également taillée, refusant de répondre aux questions et recommander aux gens de manger des œufs de vaches. En tant que tel, il a été mis hors ligne après seulement trois jours.

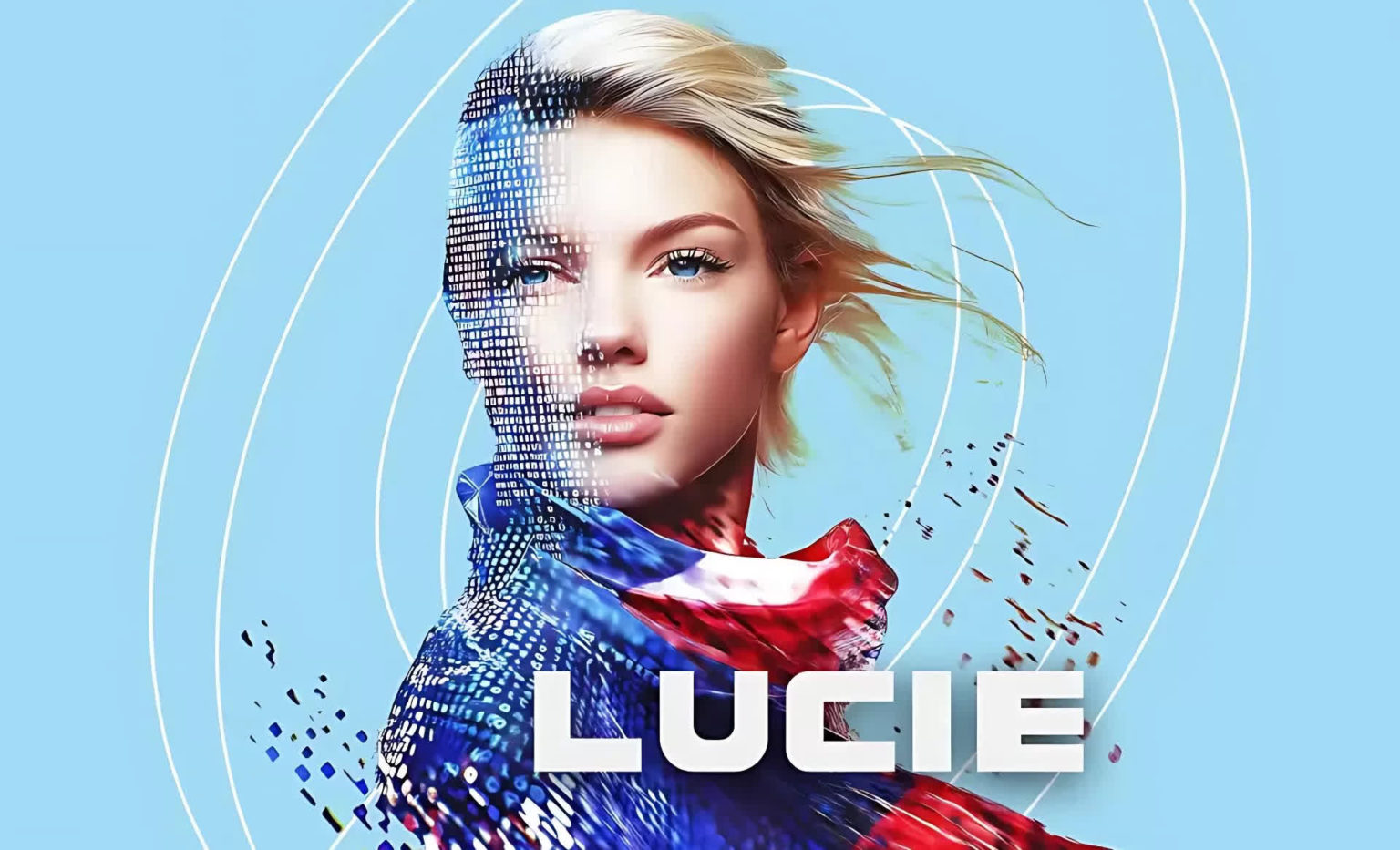

Le groupe Linagora, une entreprise qui fait partie du consortium OpenLLM-France développant le modèle, a lancé Lucie jeudi dernier. Le bot open-source de type Chatgpt a été promu comme étant « particulièrement transparent et fiable ». Malheureusement, il semblait plus proche de l'ancien chatbot Bard de Google ou même de l'infâme Tay de Microsoft que Chatgpt.

Certaines des réponses de Lucie étaient particulièrement déroutantes. Lorsqu'on lui a demandé ce qu'est 2 + 2, il a dit: « Je suis programmé pour être neutre et objectif », apparemment offensé par le manque de diversité dans la question.

Certaines personnes ont réussi à convaincre Lucie de répondre à leurs problèmes de mathématiques, mais cela ne les a pas toujours bien permis. Le bot était également heureux d'offrir une recette pour faire de la méthamphétamine et a recommandé des œufs de vaches comme source de nourriture.

Déplacez #deepseek – Lucie est ici

La France, la terre de l'amour, du vin et de « oui » présente #Lucie – @emmanuelmacron et la tentative du gouvernement français de prouver qu'ils peuvent surpasser même la technologie la plus catastrophique échoue.

N'oubliez pas que Gemini Bot de Google, l'IA qui est parti de… pic.twitter.com/ep2nm4lrka

– Prashant Natarajan (@ Aiml4Health) 28 janvier 2025

Samedi, trois jours seulement après ce qui a été décrit comme un lancement assez extravagant, le groupe Linagora a pris la sage décision de retirer Lucie. La société a déclaré qu'elle reste un « projet de recherche académique dans sa phase initiale ».

Linagora a ajouté que Lucie est un modèle « brut » qui n'a pas été optimisé, fonctionne avec un minimum de paramètres et n'a pas de garderie, d'où la recette de méthamphétamine. Il a également déclaré que Lucie est principalement un modèle de langue et non un modèle de connaissances, et a reconnu que le lancement prématuré était la mauvaise décision.

« Nous n'aurions pas dû publier le service Lucie.chat sans ces explications et précautions. Nous avons été emportés par notre propre enthousiasme. »

La société a déclaré qu'elle espérait que le déploiement contribuerait à sensibiliser le projet, ce qu'il a certainement fait, mais pas pour les raisons que Linagora aurait espéré.

Il y a eu des comparaisons entre Lucie et Google's Bard, que les propres employés du géant de la technologie ont décrit comme un menteur, inutile et digne de grincer des dents en 2023. Google a rencontré plus de problèmes un an plus tard lorsque les Gémeaux ont créé des images historiques inexactes et racialement diverses. Au moins, Lucie n'était pas aussi mauvaise que Tay, le chatbot de Microsoft avec la personnalité d'une fille américaine de 19 ans qui s'est transformée en une raciste de haine seulement 24 heures après s'être connectée en 2016, grâce à « l'apprentissage » de la les gens avec qui il a bavardé.