Un nouveau GPU monstre débarque pour dynamiser la prochaine génération d’IA générative

Pourquoi est-ce important: La course à l’IA générative ne montre aucun signe de ralentissement et Nvidia cherche à en tirer pleinement parti avec l’introduction d’une nouvelle superpuce d’IA, le GPU H200 Tensor Core. La plus grande amélioration par rapport à son prédécesseur est l’utilisation de la mémoire HBM3e, qui permet une plus grande densité et une bande passante mémoire plus élevée, deux facteurs cruciaux pour améliorer la vitesse de services comme ChatGPT et Google Bard.

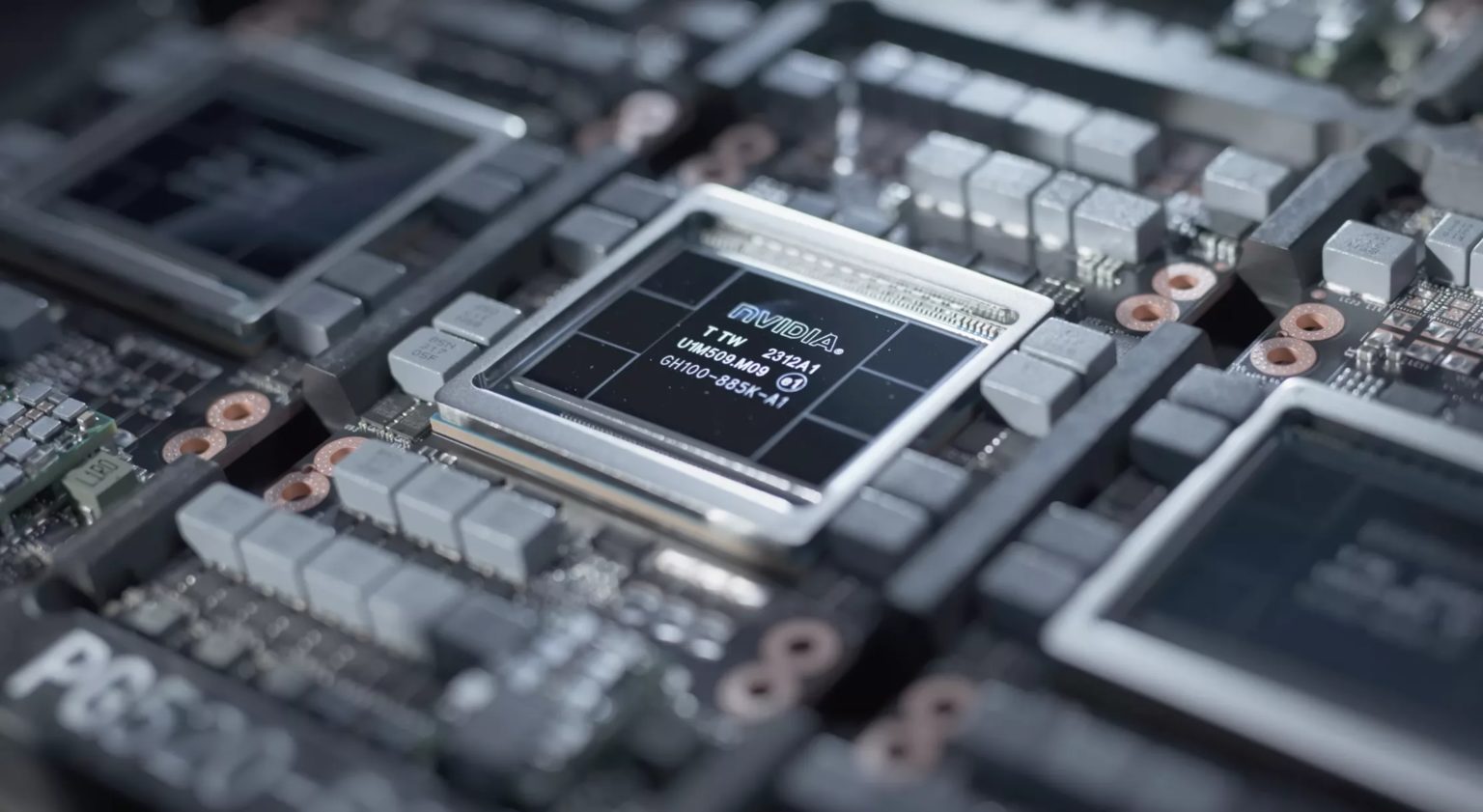

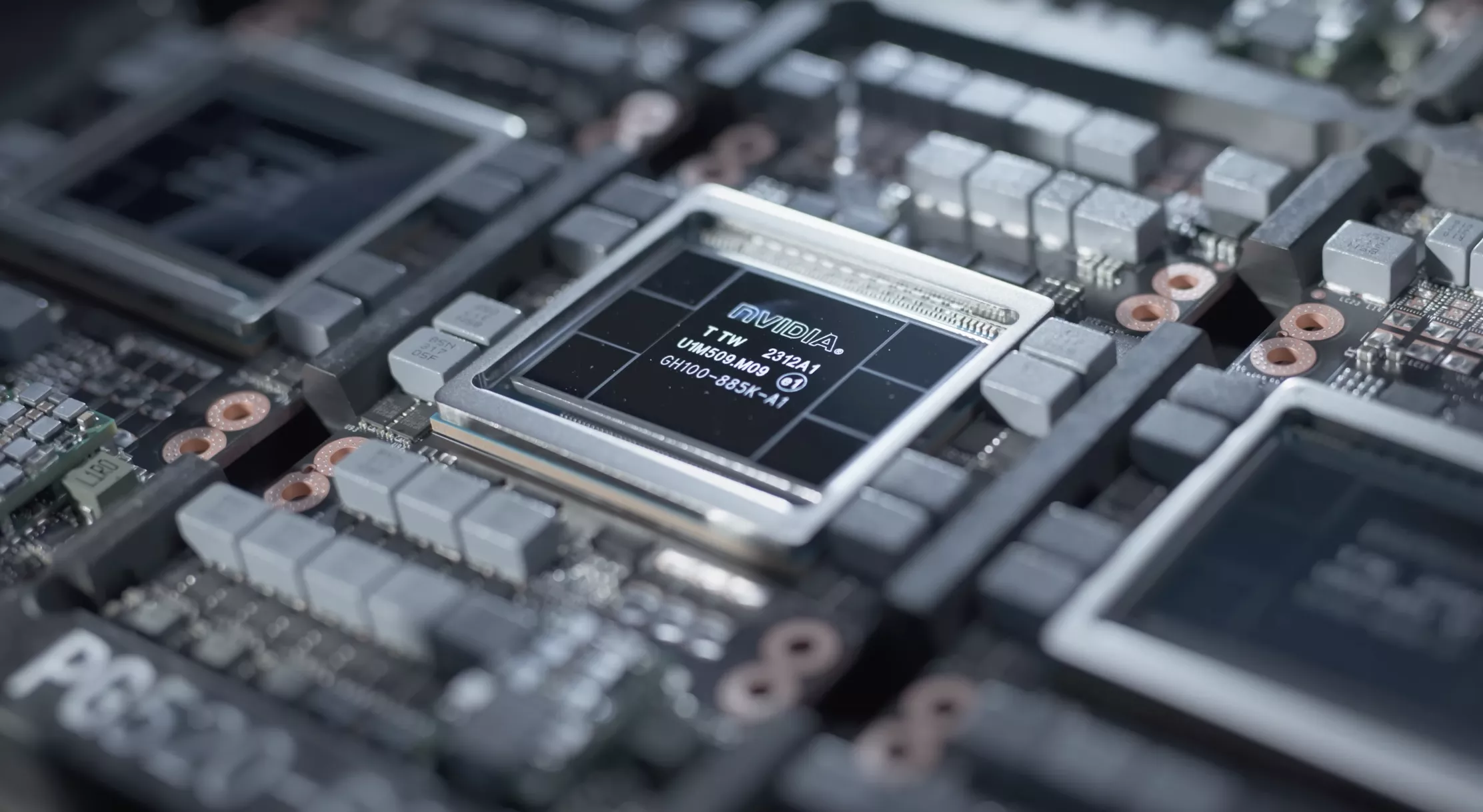

Nvidia a présenté cette semaine une nouvelle unité de traitement monstre pour les charges de travail d’IA, le HGX H200. Comme son nom l’indique, la nouvelle puce est le successeur du très populaire GPU H100 Tensor Core qui a fait ses débuts en 2022 lorsque le train à la mode de l’IA générative a commencé à prendre de la vitesse.

Team Green a annoncé la nouvelle plate-forme lors de la conférence Supercomputing 2023 à Denver, Colorado. Basé sur l’architecture Hopper, le H200 devrait offrir une vitesse d’inférence presque deux fois supérieure à celle du H100 sur Llama 2, qui est un grand modèle de langage (LLM) avec 70 milliards de paramètres. Le H200 fournit également une vitesse d’inférence environ 1,6 fois supérieure lors de l’utilisation du modèle GPT-3, qui comporte 175 milliards de paramètres.

Certaines de ces améliorations de performances proviennent d’améliorations architecturales, mais Nvidia affirme avoir également effectué un travail d’optimisation approfondi sur le plan logiciel. Cela se reflète dans la récente publication de bibliothèques de logiciels open source telles que TensorRT-LLM, qui peuvent offrir des performances jusqu’à huit fois supérieures et une consommation d’énergie jusqu’à six fois inférieure lors de l’utilisation des derniers LLM pour l’IA générative.

Un autre point fort de la plate-forme H200 est qu’elle est la première à utiliser la spécification Fester, la mémoire HBM3e. La bande passante mémoire totale du nouveau GPU Tensor Core est de 4,8 téraoctets par seconde, un peu plus rapide que les 3,35 téraoctets par seconde atteints par le sous-système de mémoire du H100. La capacité totale de mémoire est également passée de 80 Go sur le H100 à 141 Go sur la plateforme H200.

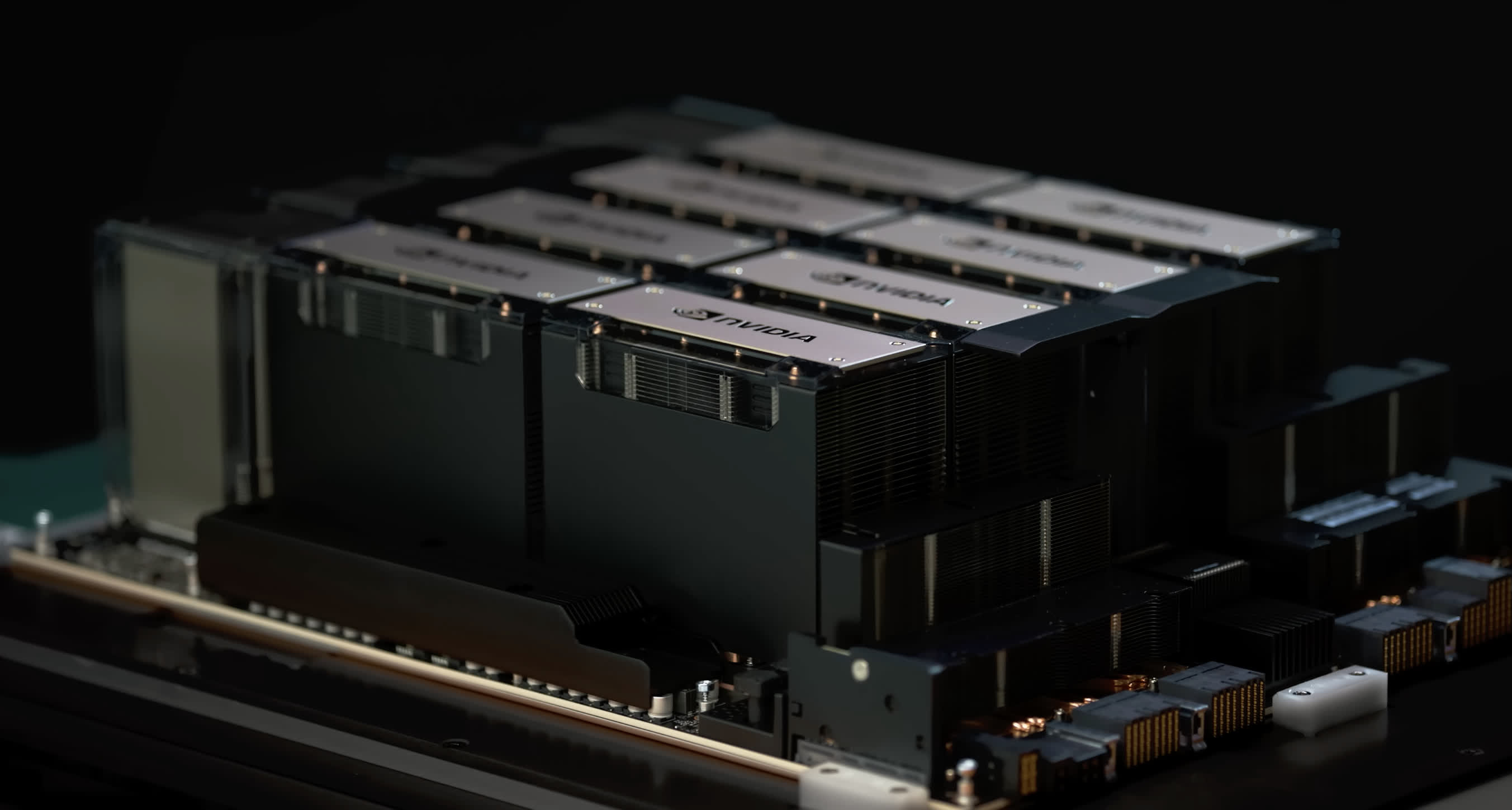

Nvidia affirme que le H200 est conçu pour être compatible avec les mêmes systèmes qui prennent en charge le GPU H100. Cela dit, le H200 sera disponible sous plusieurs facteurs de forme, tels que les cartes serveur HGX H200 avec des configurations à quatre ou huit voies ou en tant que superpuce GH200 Grace Hopper où il sera associé à un puissant processeur Arm à 72 cœurs sur le même processeur. conseil. Le GH200 permettra jusqu’à 1,1 téraoctets de mémoire globale à large bande passante et 32 pétaflops de performances FP8 pour les applications d’apprentissage en profondeur.

Tout comme le GPU H100, la nouvelle superpuce Hopper sera très demandée et coûtera très cher. Un seul H100 se vend entre 25 000 et 40 000 dollars, selon le volume des commandes, et de nombreuses entreprises du secteur de l’IA les achètent par milliers. Cela oblige les petites entreprises à s’associer simplement pour obtenir un accès limité aux GPU AI de Nvidia, et les délais de livraison ne semblent pas raccourcir avec le temps.

En parlant de délais de livraison, Nvidia réalise un énorme bénéfice sur chaque H100 vendu, elle a donc même déplacé une partie de la production de la série RTX 40 vers la fabrication de davantage de GPU Hopper. Kristin Uchiyama de Nvidia affirme que l’approvisionnement ne sera pas un problème car la société travaille constamment à l’augmentation de sa capacité de production, mais a refusé de fournir plus de détails à ce sujet.

Une chose est sûre : Team Green est beaucoup plus intéressé par la vente de GPU axés sur l’IA, car les ventes de puces Hopper représentent une part de plus en plus importante de ses revenus. Il fait même de grands efforts pour développer et fabriquer des versions réduites de ses puces A100 et H100 simplement pour contourner les contrôles américains à l’exportation et les expédier aux géants technologiques chinois. Il est donc difficile d’être trop enthousiasmé par les prochaines cartes graphiques RTX 4000 Super, car la disponibilité sera un facteur important dans leur prix de détail.

Microsoft Azure, Google Cloud, Amazon Web Services et Oracle Cloud Infrastructure seront les premiers fournisseurs de cloud à offrir l’accès aux instances basées sur H200 à partir du deuxième trimestre 2024.