Certains diront que l’IA est une mode et que la prochaine bulle attend d’éclater.

Le point de vue de l’éditeur : Comme presque tout le monde dans la technologie aujourd’hui, nous avons passé l’année dernière à essayer de comprendre « l’IA ». Qu’est-ce que c’est, comment cela fonctionne et ce que cela signifie pour l’industrie. Nous ne sommes pas sûrs d’avoir de bonnes réponses, mais certaines choses sont claires. Peut-être que l’AGI (intelligence artificielle générale) émergera, ou que nous assisterons à une autre avancée majeure en matière d’IA, mais trop se concentrer sur ces risques pourrait être négliger les améliorations très réelles – mais aussi très banales – que les réseaux de transformateurs apportent déjà.

Une partie de la difficulté d’écrire cet article réside dans le fait que nous sommes coincés dans une sorte de dilemme. D’une part, nous ne voulons pas ignorer les progrès de l’IA. Ces nouveaux systèmes sont des avancées techniques importantes, ce ne sont pas des jouets uniquement destinés à générer des images de d’adorables chatons habillés à la manière des maîtres hollandais contemplant une assiette de fruits comme sur l’image ci-dessous (généré par Microsoft Copilot). Il ne faut pas les écarter facilement.

Note de l’éditeur:

L’auteur invité Jonathan Goldberg est le fondateur de D2D Advisory, un cabinet de conseil multifonctionnel. Jonathan a développé des stratégies de croissance et des alliances pour des entreprises des secteurs de la téléphonie mobile, des réseaux, des jeux et des logiciels.

D’un autre côté, l’écrasante majorité des commentaires publics sur l’IA sont absurdes. Personne avec qui nous avons parlé travaillant actuellement dans ce domaine ne pense que nous sommes à l’aube de l’intelligence générale artificielle (IAG). Peut-être que nous ne sommes qu’à une avancée décisive, mais nous ne trouvons personne qui croit vraiment que cela est probable. Malgré cela, les médias généralistes regorgent de toutes sortes d’histoires qui confondent IA générative et AGI, avec toutes sortes d’opinions farfelues et non fondées sur ce que cela signifie.

Mettant de côté tout le bruit, et il y a beaucoup de bruit, ce que nous avons vu au cours de la dernière année a été la montée en puissance des réseaux de neurones basés sur Transformer. Nous utilisons des systèmes probabilistes en calcul depuis des années, et les transformateurs constituent une méthode meilleure, ou plus économique, pour effectuer ce calcul.

Ceci est important car cela ouvre l’espace des problèmes que nous pouvons résoudre avec nos ordinateurs. Jusqu’à présent, cela relevait en grande partie du domaine du traitement du langage naturel et de la manipulation d’images. Celles-ci sont importantes, parfois même utiles, mais elles s’appliquent à ce qui constitue encore une part assez limitée de l’expérience utilisateur et des applications. Les ordinateurs capables de traiter efficacement le langage humain seront très utiles, mais ne constitueront pas une sorte de percée informatique universelle.

Cela ne signifie pas que « l’IA » n’apporte qu’une petite quantité de valeur, mais cela signifie qu’une grande partie de cette valeur viendra de manière assez banale. Nous pensons que cette valeur devrait être divisée en deux catégories : les expériences d’IA générative et les améliorations de bas niveau des logiciels.

Prenez ce dernier – les améliorations logicielles. Cela semble ennuyeux – c’est le cas – mais cela ne veut pas dire que cela est sans importance. Aujourd’hui, toutes les grandes sociétés de logiciels et d’Internet intègrent des transformateurs dans leurs piles. Pour la plupart, cela passera totalement inaperçu auprès des utilisateurs.

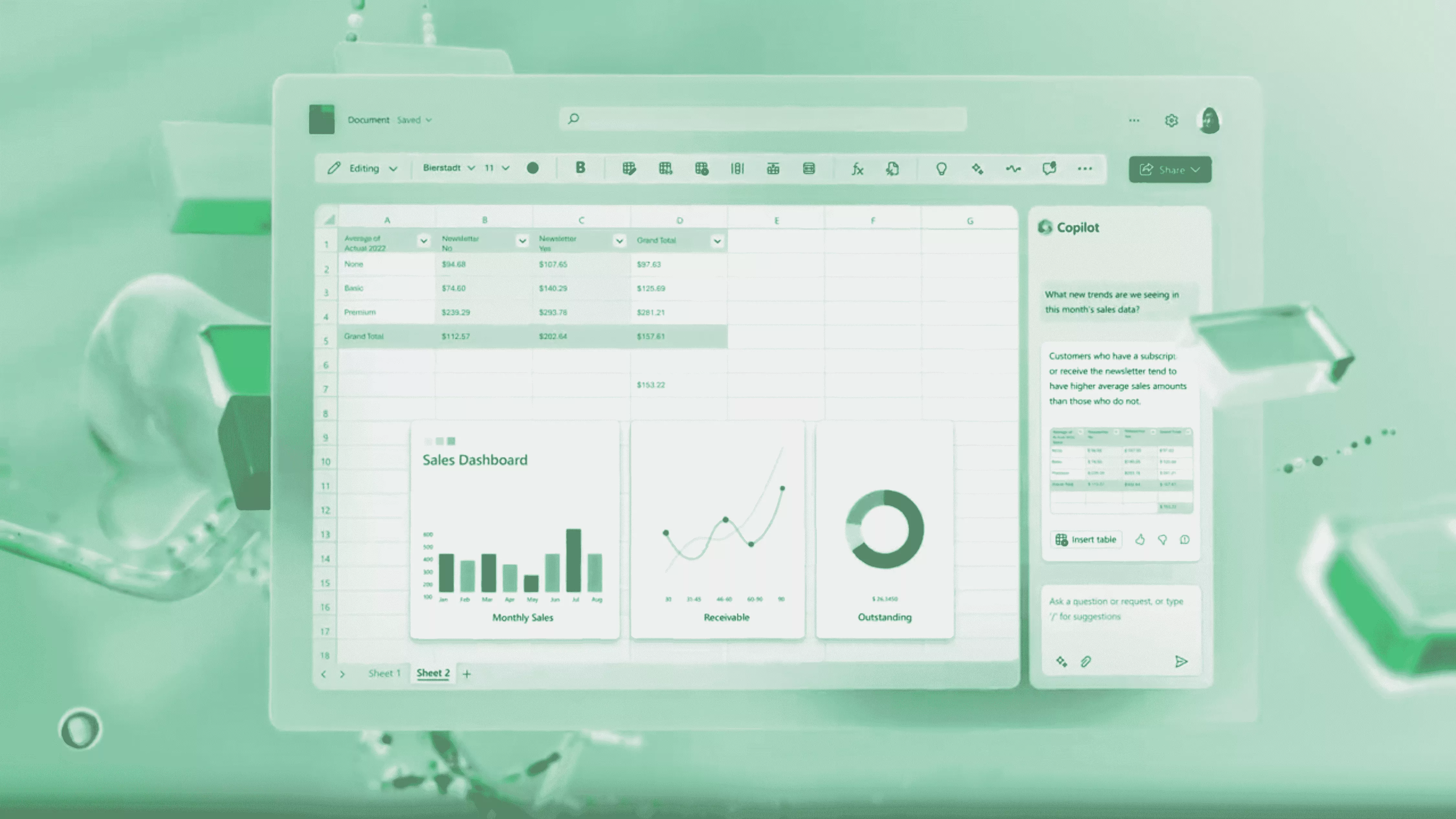

Nous imaginons que Microsoft pourrait avoir des fonctionnalités vraiment intéressantes à ajouter à MS Word, PowerPoint et Visual Basic. Bien sûr, allez-y et impressionnez-nous avec AI Excel. Mais c’est beaucoup d’espoir pour une entreprise qui n’est pas connue pour proposer d’excellentes interfaces utilisateur.

Les entreprises de sécurité peuvent améliorer un peu leurs produits pour détecter les menaces. Les systèmes CRM peuvent s’améliorer un peu pour faire correspondre les demandes des utilisateurs aux résultats utiles. Les fabricants de puces amélioreront dans une certaine mesure la prévision des branches de processeur. Il s’agit là de gains infimes, d’une augmentation des performances de 10 ou 20 % ou d’une réduction des coûts. Et ce n’est pas grave, cela représente toujours une valeur considérable lorsqu’elle est combinée à tous les logiciels disponibles. Pour le moment, nous pensons que la grande majorité des gains de « l’IA » se produiront sous ces formes banales mais utiles.

L’IA générative pourrait s’avérer plus importante. Peut être. Une partie du problème que nous rencontrons aujourd’hui dans ce domaine réside dans le fait qu’une grande partie de l’industrie technologique attend de voir ce que tout le monde fera sur ce front.

Dans tous leurs récents commentaires publics, toutes les grandes entreprises de processeurs ont souligné la prochaine mise à jour de l’IA de Microsoft comme un catalyseur majeur pour l’adoption des semi-IA de l’IA. Nous imaginons que Microsoft pourrait avoir des fonctionnalités vraiment intéressantes à ajouter à MS Word, PowerPoint et Visual Basic. Bien sûr, allez-y et impressionnez-nous avec AI Excel. Mais c’est beaucoup d’espoir de s’accrocher à une seule entreprise, en particulier une entreprise comme Microsoft qui n’est pas connue pour proposer d’excellentes interfaces utilisateur.

De son côté, Google semble être un cerf dans les phares en matière de transformateurs, ironique étant donné qu’ils les ont inventés. En fin de compte, tout le monde attend vraiment qu’Apple nous montre comment bien faire les choses. Jusqu’à présent, ils ont été remarquablement discrets sur l’IA générative. Peut-être qu’ils sont aussi confus que tout le monde, ou peut-être qu’ils n’en voient tout simplement pas encore l’utilité.

Apple utilise des processeurs neuronaux dans ses téléphones depuis des années. Ils n’ont pas tardé à ajouter la prise en charge des transformateurs aux processeurs de la série M. Il ne semble pas juste de dire qu’ils sont à la traîne en matière d’IA, alors qu’ils attendent peut-être simplement.

En revenant aux semi-conducteurs, il peut être tentant de susciter de grandes attentes et d’élaborer des scénarios sur toutes les manières dont l’IA stimulera de nouvelles activités. D’où le nombre croissant de commentaires sur les PC IA et le marché des semi-conducteurs d’inférence. Nous ne sommes pas convaincus et il n’est pas certain qu’aucune de ces entreprises soit réellement capable de créer des marchés massifs dans ces domaines.

Au lieu de cela, nous avons tendance à voir l’avènement des systèmes d’IA basés sur des transformateurs en des termes beaucoup plus simples. La montée en puissance des transformateurs semble en grande partie signifier un transfert d’influence et de capture de valeur vers Nvidia aux dépens d’Intel dans le domaine des centres de données. AMD peut se tailler sa part de ce transfert, et peut-être qu’Intel peut organiser le retour de tous les retours, mais dans un avenir prévisible, il n’est pas nécessaire de compliquer les choses.

Cela dit, nous nous trompons peut-être. Peut-être qu’il y a de gros gains à venir, une avancée majeure d’un laboratoire de recherche ou d’une startup de pré-produit déca-licorne. Nous n’éliminerons pas cette possibilité. Ce que nous voulons dire ici, c’est simplement que nous constatons déjà des gains significatifs grâce aux transformateurs et autres systèmes d’IA. Toutes ces améliorations logicielles « cachées » sont déjà significatives, et nous ne devrions pas nous inquiéter d’attendre l’émergence de quelque chose d’encore plus grand.

Certains diront que l’IA est une mode, la prochaine bulle attendant d’éclater. Nous sommes plus optimistes que cela, mais cela vaut la peine de réfléchir à ce à quoi pourraient ressembler les inconvénients des demi-finales de l’IA…

Nous sommes assez optimistes quant aux perspectives de l’IA, même si elles se situent dans des domaines résolument banals. Mais nous n’en sommes qu’aux premiers jours de cette transition, avec de nombreuses inconnues. Nous sommes conscients qu’il existe une tendance parmi certains investisseurs à penser que nous sommes dans une « bulle de l’IA », et la forme dure de cette thèse soutient que l’IA n’est qu’une mode passagère et qu’une fois la bulle dégonflée, le marché des semi-conducteurs reviendra à le statu quo d’il y a deux ans.

Quelque part entre les extrêmes, l’IA est si puissante qu’elle mettra fin à la race humaine et l’IA est un jouet inutile, ce qui représente un inconvénient beaucoup plus léger pour les semi-conducteurs.

D’après ce que nous pouvons évaluer à l’heure actuelle, le consensus semble considérer que le marché des semi-remorques IA contribuera légèrement à la demande globale. Les entreprises devront toujours dépenser des milliards en processeurs et en calcul traditionnel, mais auront désormais besoin de capacités d’IA nécessitant l’achat de GPU et d’accélérateurs.

Au cœur de cette affaire se trouve le marché des semi-inférences. À mesure que les modèles d’IA se généralisent, la majeure partie de la demande en IA diminuera dans ce domaine, ce qui rendra l’IA utile aux utilisateurs. Il existe quelques variantes dans ce cas. Une partie de la demande en CPU disparaîtra lors de la transition vers l’IA, mais ce n’est pas un enjeu important. Et les investisseurs peuvent débattre de la part d’inférence qui sera exécutée dans le cloud par rapport à la périphérie, et qui paiera ces investissements. Mais il s’agit essentiellement du cas de base. Bon pour Nvidia, avec beaucoup de marché d’inférence restant pour tous les autres sur un marché en croissance.

Les inconvénients se présentent en réalité sous deux formes. La première se concentre sur la taille de ce marché d’inférence. Comme nous l’avons mentionné à plusieurs reprises, on ne sait pas exactement quelle sera la demande pour les semi-conducteurs d’inférence. Le problème le plus flagrant se situe à la périphérie. Même si les utilisateurs semblent aujourd’hui séduits par l’IA générative, prêts à payer plus de 20 $/mois pour accéder aux dernières nouveautés d’OpenAI, les arguments en faveur de la réalisation de cette IA générative sur l’appareil ne sont pas clairs.

Les gens paieront pour OpenAI, mais paieront-ils vraiment un dollar supplémentaire pour l’exécuter sur leur appareil plutôt que sur le cloud ? Comment pourront-ils même faire la différence ? Certes, il existe des raisons légitimes pour lesquelles les entreprises ne souhaitent pas partager leurs données et leurs modèles avec des tiers, ce qui nécessiterait une inférence sur l’appareil. D’un autre côté, cela semble être un problème résolu par un groupe d’avocats et un accord de licence rédigé de manière stricte, ce qui est sûrement beaucoup plus abordable que la construction d’un tas de racks de serveurs GPU (si vous pouviez même en trouver à acheter).

Tout cela veut dire que des entreprises comme AMD, Intel et Qualcomm, qui ont de grandes attentes en matière d’IA sur appareil, auront du mal à facturer un supplément pour leurs processeurs prêts pour l’IA. Lors de sa dernière conférence téléphonique sur les résultats, le PDG de Qualcomm a présenté les arguments en faveur d’un Snapdragon prêt pour l’IA comme apportant une amélioration positive au changement de mix, ce qui est une manière polie de dire des augmentations de prix limitées pour un petit sous-ensemble de produits.

Le marché de l’inférence cloud devrait être bien meilleur, mais même ici, des questions subsistent quant à la taille du marché. Et si les modèles étaient suffisamment réduits pour pouvoir fonctionner assez bien sur les processeurs ? C’est techniquement possible, la préférence pour les GPU et les accélérateurs est fondamentalement une question économique, mais changez quelques variables et pour de nombreux cas d’utilisation, l’inférence CPU est probablement suffisante pour de nombreuses charges de travail. Cela serait catastrophique, ou du moins très mauvais, pour les attentes de tous les fabricants de processeurs.

Le scénario le plus effrayant est probablement celui dans lequel l’IA générative disparaît en tant que produit de consommation. Utile pour programmer et créer des spams accrocheurs, mais rien d’autre. Il s’agit là du véritable cas d’ours pour Nvidia, non pas de quelques gains nominaux de parts d’AMD, mais d’un manque de cas d’utilisation convaincants. C’est pourquoi nous sommes nerveux devant la mesure dans laquelle tous les fabricants de processeurs semblent si dépendants de la prochaine actualisation de Windows de Microsoft pour susciter l’intérêt des consommateurs pour cette catégorie.

En fin de compte, nous pensons que le marché des semi-remorques IA continuera de croître, générant une demande saine dans l’ensemble du secteur. Probablement pas autant que certains l’espèrent, mais loin d’être le pire des cas, le camp « l’IA est une mode ».

Il faudra encore quelques cycles pour trouver les cas d’utilisation intéressants de l’IA, et il n’y a aucune raison de penser que Microsoft est la seule entreprise capable d’innover ici. Tout cela nous place fermement au milieu des attentes : la demande structurelle à long terme va croître, mais il y aura des hauts et des bas avant d’y arriver, et probablement pas de zombies post-apocalyptiques à craindre.