L'architecture révolutionnaire BitNet est la clé d'une IA respectueuse du processeur

Bref: Un groupe de chercheurs en intelligence artificielle a démontré l'exécution d'un puissant modèle de langage d'IA sur une machine Windows 98. Et nous ne parlons pas de n'importe quel vieux PC, mais d'un système Pentium II vintage avec seulement 128 Mo de RAM. L'équipe à l'origine de l'expérience est EXO Labs, une organisation formée de chercheurs et d'ingénieurs de l'Université d'Oxford.

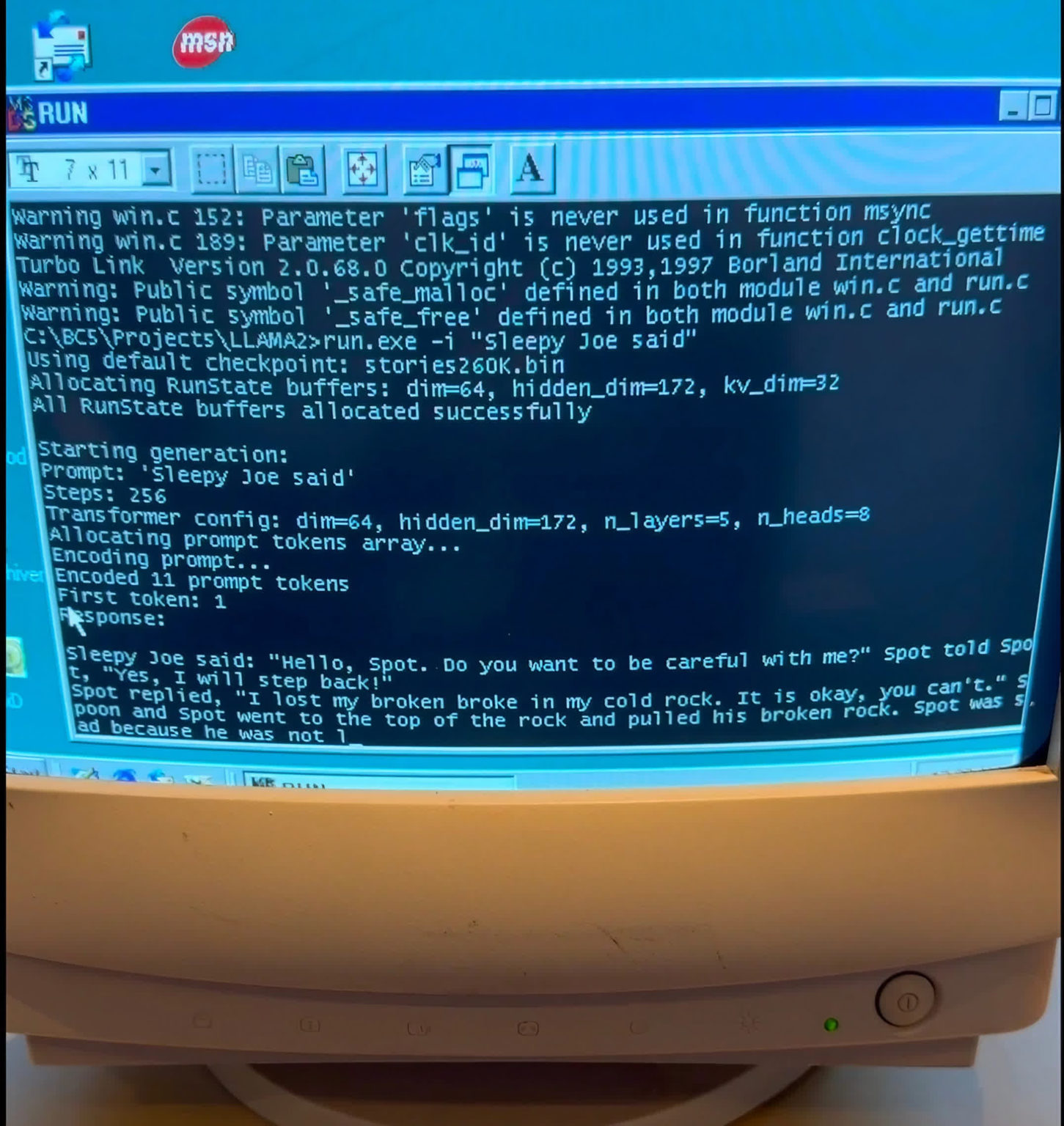

Dans une vidéo partagée sur X, EXO Labs a lancé un système poussiéreux Elonex Pentium II 350 MHz exécutant Windows 98. Au lieu de jouer au Démineur ou de naviguer avec Netscape Navigator, le PC a été mis à l'épreuve avec quelque chose de bien plus exigeant : exécuter un modèle d'IA.

Ce modèle était basé sur le code Llama2.c d'Andrej Karpathy. Contre toute attente, l’ordinateur a réussi à générer une histoire cohérente sur commande. Il l’a également fait à une vitesse décente, ce qui est généralement difficile avec les modèles d’IA exécutés localement.

Le rythme est déjà un défi assez important, mais un autre obstacle que l'équipe a dû surmonter était de compiler et d'exécuter du code moderne sur un système d'exploitation de 1998.

Finalement, ils ont réussi à maintenir une performance de 39,31 jetons par seconde en exécutant un LLM basé sur Llama avec 260 000 paramètres. Cependant, l’augmentation de la taille du modèle a considérablement réduit les performances. Par exemple, le modèle Llama 3.2 à 1 milliard de paramètres gérait à peine 0,0093 jetons par seconde sur le matériel vintage.

Quant à savoir pourquoi l’équipe s’efforce d’exécuter des modèles d’IA qui nécessitent généralement un matériel serveur puissant sur des machines aussi anciennes, l’objectif est de développer des modèles d’IA pouvant fonctionner même sur les appareils les plus modestes. La mission d'EXO Labs est de « démocratiser l'accès à l'IA » et d'empêcher une poignée de géants de la technologie de monopoliser cette technologie révolutionnaire.

35,9 tok/sec sous Windows 98 🤯

Il s'agit d'un LLM 260K avec une architecture Lama.

Nous avons également essayé des modèles plus grands. Résultats dans le billet de blog. https://t.co/QsViEQLqS9 pic.twitter.com/lRpIjERtSr

– Alex Cheema – e/acc (@alexocheema) 28 décembre 2024

Pour cela, la société développe ce qu'elle appelle « BitNet » – une architecture de transformateur qui utilise des poids ternaires pour réduire considérablement la taille du modèle. Avec cette architecture, un modèle à 7 milliards de paramètres n'a besoin que de 1,38 Go de stockage, ce qui permet de l'exécuter sur la plupart des matériels économiques.

BitNet est également conçu pour être axé sur le processeur, évitant ainsi le recours à des GPU coûteux. Plus impressionnant encore, l'architecture peut exploiter un modèle stupéfiant de 100 milliards de paramètres sur un seul processeur tout en maintenant des vitesses de lecture humaine de 5 à 7 jetons par seconde.

Si vous souhaitez rejoindre la révolution des modèles gérés localement, EXO Labs recherche activement des contributeurs. Consultez simplement l’article de blog complet pour avoir une meilleure idée de la mission.