La fonctionnalité arrivera sur Facebook, Instagram et Threads dans les mois à venir

Une patate chaude : À mesure que l’IA générative devient de plus en plus avancée et accessible, de plus en plus de fausses images apparaissent sur les réseaux sociaux aux côtés d’affirmations selon lesquelles elles sont authentiques. Meta affirme qu’elle luttera contre ce problème en détectant et en étiquetant les images d’IA publiées sur ses plateformes – Facebook, Instagram et Threads – même lorsqu’elles sont créées par des services concurrents.

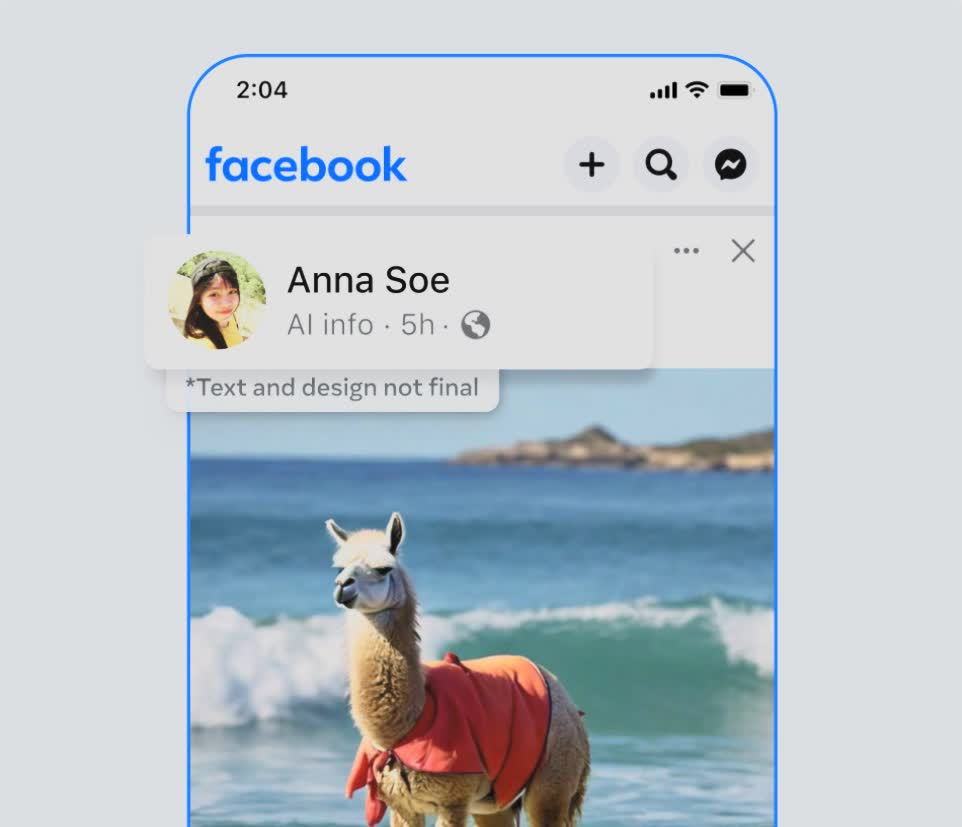

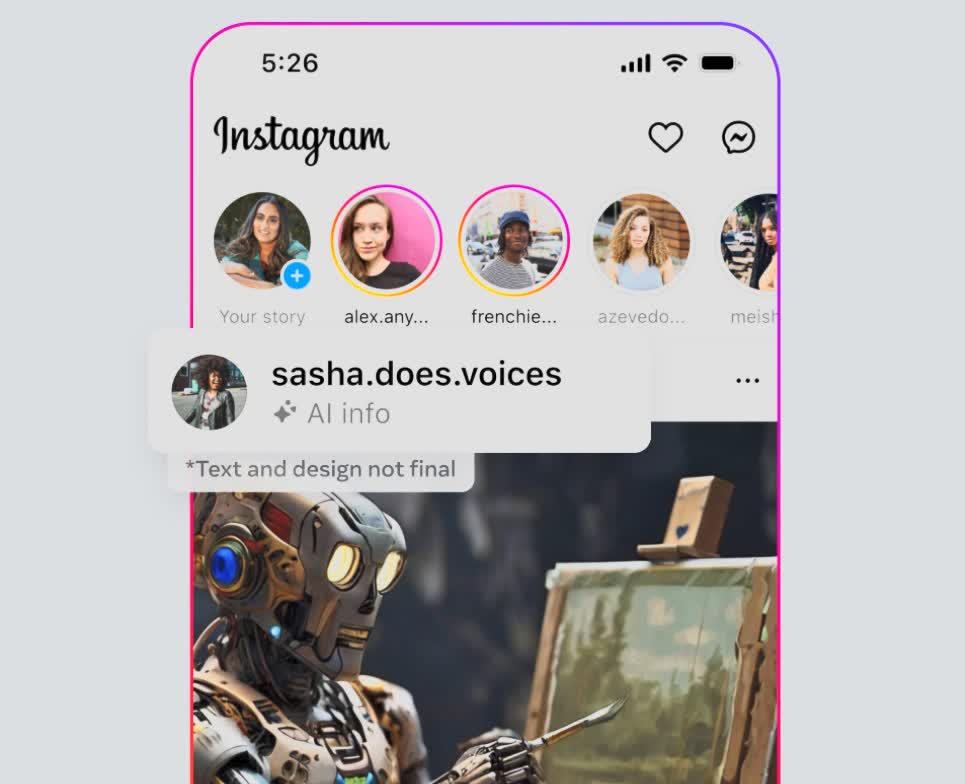

Meta étiquette déjà les images photoréalistes créées par son outil d’IA avec les étiquettes « Imaginé avec l’IA », et souhaite faire la même chose avec le contenu créé par d’autres services d’IA générative, écrit Nick Clegg, président des affaires mondiales de Meta.

Les images photoréalistes créées avec l’outil d’IA de Meta incluent des marqueurs visibles, des filigranes invisibles et des métadonnées intégrées dans les fichiers image pour aider les plateformes à les identifier comme étant générées par l’IA.

Clegg écrit que Meta a travaillé avec d’autres sociétés pour développer des normes communes pour identifier le contenu généré par l’IA. Le géant des médias sociaux crée des outils qui identifient les marqueurs invisibles à grande échelle afin que les images de Google, OpenAI, Microsoft, Adobe, Midjourney et Shutterstock, qui travaillent pour ajouter leurs propres métadonnées aux images, puissent être identifiées et étiquetées lorsqu’elles sont publiées sur un Meta. plate-forme.

« Les gens découvrent souvent du contenu généré par l’IA pour la première fois et nos utilisateurs nous ont dit qu’ils apprécient la transparence autour de cette nouvelle technologie. Il est donc important que nous aidions les gens à savoir quand le contenu photoréaliste qu’ils voient a été créé à l’aide de l’IA. » Clegg a écrit.

Meta renforce désormais sa capacité à identifier les images générées par l’IA et commencera à appliquer des étiquettes dans toutes les langues sur ses applications dans les mois à venir.

Clegg a déclaré que l’identification du contenu audio et vidéo créé par l’IA s’avère plus difficile car le processus d’ajout de marqueurs est compliqué. Cependant, Meta ajoute une fonctionnalité qui permettra aux utilisateurs de divulguer lorsqu’ils partagent une vidéo ou un audio généré par l’IA afin que l’entreprise puisse y ajouter une étiquette. Les utilisateurs doivent également utiliser cet outil de divulgation lorsqu’ils publient du contenu organique avec une vidéo photoréaliste ou un audio réaliste créé ou modifié numériquement. Meta « peut appliquer des sanctions s’ils ne le font pas ».

Clegg a déclaré que toute image, vidéo ou audio créé ou modifié numériquement qui « crée un risque particulièrement élevé de tromper matériellement le public sur une question importante » recevra une étiquette plus visible.

Meta travaille également au développement de classificateurs qui peuvent l’aider à détecter automatiquement le contenu généré par l’IA, même si ledit contenu manque de marqueurs invisibles. Il étudie également les moyens de rendre plus difficile la modification ou la suppression des filigranes invisibles.

À l’approche des élections, de plus en plus d’entreprises cherchent des moyens d’identifier les contenus trompeurs générés par l’IA. En septembre, Microsoft a mis en garde contre l’utilisation d’images d’IA provenant de Chine pour influencer les électeurs américains.

Plus récemment, un appel automatisé a été envoyé aux résidents du New Hampshire, comprenant un message de 39 secondes prononcé par ce qui ressemblait à un président Biden leur disant de ne pas voter. Il a probablement été créé à l’aide d’un moteur de synthèse vocale créé par ElevenLabs, ce qui a conduit la FCC à voter pour interdire les voix de l’IA dans les appels automatisés.